I. บทสรุปสำหรับผู้บริหาร: ความจำเป็นเชิงกลยุทธ์ของผู้ช่วยเขียนโค้ดด้วย AI

สรุป A: ความแตกต่างของ “ดีที่สุด”: ความเร็วเทียบกับคุณภาพ

ข้อสรุปหลักของการวิเคราะห์นี้คือ ไม่มีเครื่องมือ AI ใดเพียงเครื่องมือเดียวที่ถือว่า “ดีที่สุด” อย่างเด็ดขาด องค์กรที่มุ่งหวังประสิทธิภาพสูงสุดจะต้องใช้ กลยุทธ์การเพิ่มประสิทธิภาพพอร์ตโฟลิโอเครื่องมือ ซึ่งจะมีการประยุกต์ใช้เครื่องมือเฉพาะทางให้เข้ากับแต่ละขั้นตอนของวัฏจักรการพัฒนาซอฟต์แวร์ (Software Development Life Cycle – SDLC) 1 แนวทางนี้ช่วยเพิ่มทั้งความเร็วในการพัฒนาและคุณภาพของโค้ด ด้วยการใช้จุดแข็งหลักของผู้นำตลาดแต่ละราย

เครื่องมือสำคัญที่โดดเด่นในตลาดปัจจุบัน ได้แก่:

- GitHub Copilot: เป็นผู้นำที่ไม่มีใครโต้แย้งในด้านความเร็ว การสร้างโค้ดส่วนเริ่มต้น (boilerplate generation) และการรักษาสภาวะ “Flow State” ของนักพัฒนาผ่านการผนวกเข้ากับสภาพแวดล้อมการพัฒนาแบบไร้รอยต่อ (IDE integration) 1

- Anthropic Claude 3 (Opus Tier): โดดเด่นกว่าในด้านการใช้เหตุผลที่ซับซ้อน การแก้ไขปัญหาเชิงสถาปัตยกรรม การดีบัก และการบรรลุความถูกต้องของโค้ดในระดับสูงตามเกณฑ์มาตรฐานที่เข้มงวด เช่น SWE-bench 3

ดังนั้น คำแนะนำเชิงกลยุทธ์สำหรับสภาพแวดล้อมการพัฒนาระดับมืออาชีพคือการใช้การผสมผสานเชิงกลยุทธ์ เช่น GitHub Copilot ควบคู่ไปกับ Claude 3 Opus เพื่อเพิ่มทั้งความเร็วในการป้อนข้อมูลและความแม่นยำของคุณภาพโค้ดให้ถึงขีดสุด 1

สรุป B: ประเด็นสำคัญเชิงกลยุทธ์ที่ต้องพิจารณา

- การเปลี่ยนตัวชี้วัดประสิทธิภาพ (Metric Shift): องค์กรต้องให้ความสำคัญกับแบบจำลองภาษาขนาดใหญ่ (LLMs) ที่ทำคะแนนได้ดีเยี่ยมในเกณฑ์มาตรฐาน SWE-bench (การแก้ไขบั๊กในโลกจริง) มากกว่าการพิจารณาเพียงแค่คะแนนที่สูงบน HumanEval ซึ่งปัจจุบันกลายเป็นเกณฑ์มาตรฐานที่ค่อนข้างพื้นฐานและวัดผลเฉพาะความสามารถพื้นฐานเท่านั้น 6

- ต้นทุนรวมในการเป็นเจ้าของเทียบกับมูลค่า (TCO vs. Value): แม้ว่า Copilot Business จะมีค่าใช้จ่ายที่คุ้มค่า (19 ดอลลาร์สหรัฐฯ ต่อผู้ใช้ต่อเดือน) 9 แต่ค่าใช้จ่ายที่สูงกว่าของ Claude Max (เริ่มต้นที่ 100 ดอลลาร์ต่อเดือน) หรือ Copilot Enterprise (39 ดอลลาร์ต่อผู้ใช้ต่อเดือน) สามารถนำมาซึ่งความสามารถเชิงตัวแทน (agentic features) และแบบจำลองการให้เหตุผลที่เหนือกว่า ซึ่งลดหนี้ทางเทคนิค (technical debt) ที่มีค่าใช้จ่ายสูงและเร่งกระบวนการตรวจสอบโค้ด (pull requests) ได้ 9

- ธรรมาภิบาลเป็นกุญแจสำคัญ (Governance is King): การนำมาใช้ในระดับองค์กรจะต้องอยู่บนพื้นฐานของกรอบการทำงานด้านความปลอดภัย ซึ่งรวมถึงการลดความเสี่ยงด้านทรัพย์สินทางปัญญา (IP risk mitigation) ด้วยตัวกรองการตรวจจับการทำซ้ำ (duplication filters) และนโยบายการเก็บรักษาข้อมูลที่แข็งแกร่ง 9

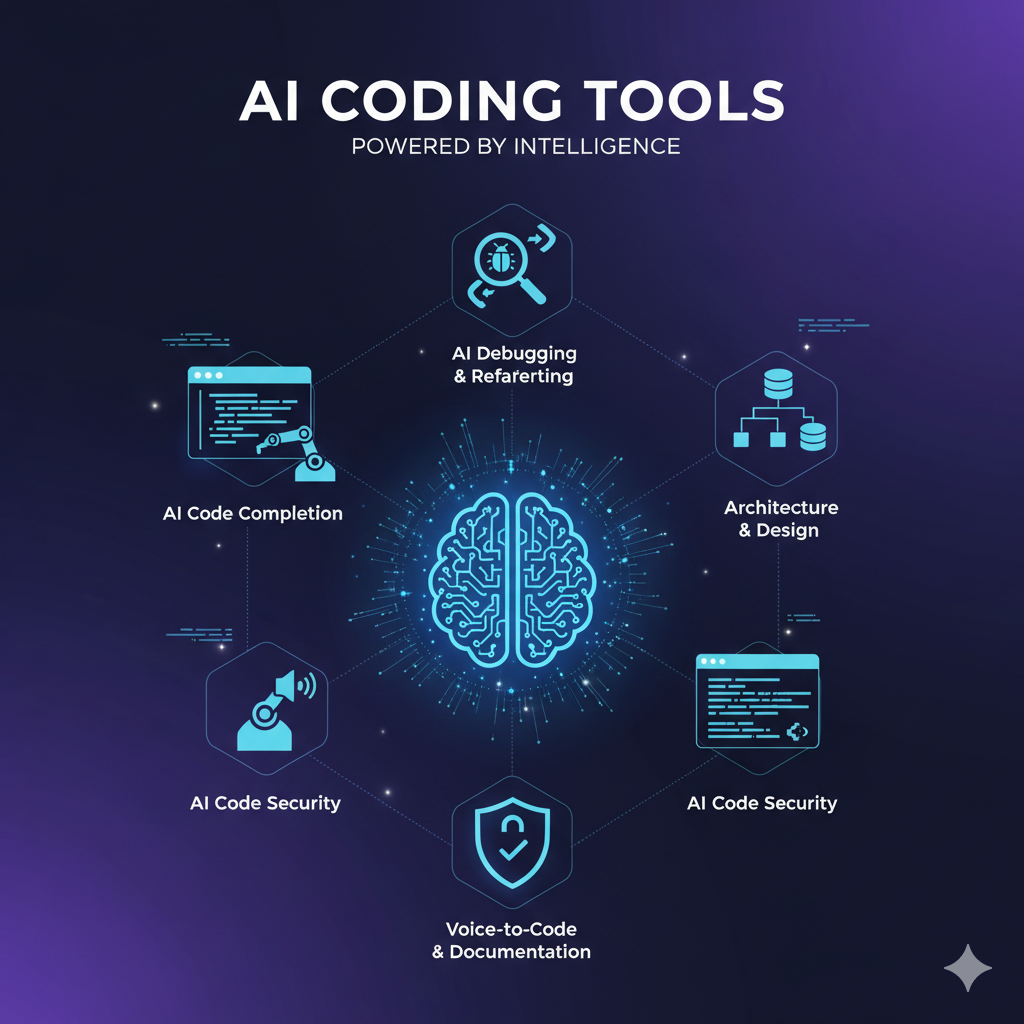

II. อนุกรมวิธานของความช่วยเหลือในการเขียนโค้ดด้วย AI: การจำแนกขั้นตอนการทำงานของนักพัฒนา

A. การแมปฟังก์ชันหลักและการแบ่งส่วนตลาด

ผู้ช่วยเขียนโค้ดด้วย AI ซึ่งขับเคลื่อนด้วยแบบจำลองภาษาขนาดใหญ่ (LLMs) สามารถช่วยนักพัฒนาในงานต่างๆ ได้หลายประเภท ซึ่งสามารถแบ่งออกตามการมุ่งเน้นด้านการเพิ่มประสิทธิภาพ 14:

- การแนะนำ/การเติมโค้ดอัตโนมัติ (เน้นความเร็ว): ผู้ช่วย AI จะแนะนำส่วนของโค้ดและฟังก์ชันที่เกี่ยวข้องกับบริบทของงานในขณะที่นักพัฒนากำลังพิมพ์ ซึ่งเป็นสิ่งสำคัญสำหรับการรักษา “Flow State” 14 GitHub Copilot เป็นผู้นำที่โดดเด่นในเซกเมนต์นี้ เนื่องจากความสามารถในการเติมโค้ดอัตโนมัติที่ยอดเยี่ยม 1

- การดีบักและการแก้ไขข้อผิดพลาด (เน้นคุณภาพ): เครื่องมือเหล่านี้ช่วยระบุข้อบกพร่องและข้อผิดพลาดในโค้ดก่อนที่จะเรียกใช้จริง 14 แบบจำลองภาษาอย่าง ChatGPT/GPT และ Claude มีความโดดเด่นในด้านนี้ เนื่องจากความสามารถในการให้เหตุผลที่เหนือกว่าในการแก้ไขข้อผิดพลาดที่ซับซ้อน 1

- การปรับโครงสร้างโค้ดและการตรวจสอบโค้ด (เน้นประสิทธิภาพ/คุณภาพ): AI ช่วยทำความสะอาดโค้ด ทำให้สามารถอ่านได้ง่ายขึ้น และปรับปรุงประสิทธิภาพ 14 Claude ได้รับการยกย่องว่าให้การตรวจสอบโค้ดและข้อเสนอแนะในการเพิ่มประสิทธิภาพที่เหนือกว่า 1

- การจัดทำเอกสารและคำอธิบาย (เน้นการเรียนรู้/การเริ่มต้น): AI แปลแนวคิดที่ซับซ้อนและโค้ดเป็นภาษาธรรมชาติเพื่อสร้างเอกสารประกอบ 14 Claude มอบ “คำอธิบายและบริบทที่ดีที่สุด” และทำหน้าที่เป็น “เครื่องมือการเรียนรู้ที่น่าทึ่ง” สำหรับนักพัฒนา 1

B. กระบวนทัศน์ทางสถาปัตยกรรม: การเติมโค้ดอัตโนมัติเทียบกับตัวแทนสนทนา

ประสบการณ์ของผู้ใช้เป็นตัวกำหนดประโยชน์ใช้สอยของเครื่องมือ AI ในทางปฏิบัติ การทำงานของ AI แบ่งออกเป็นสองกระบวนทัศน์หลัก:

- การผนวกเข้ากับ IDE โดยตรง (เช่น Copilot): เครื่องมือเหล่านี้ทำงานเป็นส่วนเสริมของโปรแกรมแก้ไขโค้ด (editor) โดยให้คำแนะนำโดยตรงแบบอินไลน์ ซึ่งมีความสำคัญอย่างยิ่งต่อความเร็ว แต่เครื่องมืออาจมีข้อจำกัดในการจัดการบริบททางสถาปัตยกรรมแบบหลายขั้นตอนหรือบริบทข้ามไฟล์หากไม่มีการแจ้งโดยชัดแจ้ง 15 จุดเด่นคือการรักษาความเร็วในการพัฒนาในระดับสูง 1

- ตัวแทนสนทนา/เว็บ UX (เช่น Claude, ChatGPT): เครื่องมือเหล่านี้ได้รับการปรับให้เหมาะสมสำหรับการสนทนาที่ซับซ้อน การวางแผน และการสร้างโค้ดในรูปแบบยาว แม้ว่าสิ่งนี้ต้องอาศัยการสลับบริบทออกจาก IDE แต่ก็อนุญาตให้มีการให้เหตุผลและคำอธิบายที่เหนือกว่า 2 การวิเคราะห์นี้ชี้ให้เห็นว่าความเร็วของ Copilot ไม่ได้เกิดจากการพิมพ์เร็วเพียงอย่างเดียว แต่เกิดจากการ

ลดภาระทางปัญญา ที่เกิดจากการกำจัดแรงเสียดทานของการสลับบริบท (เช่น การออกจาก IDE เพื่อค้นหาใน Google หรือเข้าสู่หน้าต่างแชท) 2 ในทางกลับกัน ความสามารถในการให้เหตุผลที่เหนือกว่าของ Claude ก็สามารถหักล้าง

ต้นทุน ของการสลับบริบทได้ เมื่อต้องทำงานที่ต้องการคุณภาพสูง เช่น การออกแบบสถาปัตยกรรม API เริ่มต้น หรือการดีบักบั๊กที่มีความรุนแรงสูง

แนวโน้มที่กำลังจะมาถึงคือการเปลี่ยนแปลงตลาดไปสู่ ความสามารถเชิงตัวแทน (Agentic Capabilities) 9 เครื่องมืออย่าง Amazon Q Developer Pro (19 ดอลลาร์ต่อเดือน) และ GitHub Copilot Enterprise (39 ดอลลาร์ต่อเดือน) กำลังมุ่งเน้นไปที่

คำขอเชิงตัวแทน (Agentic Requests) ซึ่งเป็นการดำเนินการแบบหลายขั้นตอนที่เป็นอิสระ เช่น การแปลงโค้ด (code transformation) หรือการลดหนี้คงค้างในรายการงาน (backlog reduction) 9 สิ่งนี้บ่งชี้ว่าอนาคตของการเขียนโค้ดด้วย AI กำลังจะก้าวข้ามจากการให้ความช่วยเหลือแบบพาสซีฟไปสู่การทำงานอัตโนมัติที่เน้นเป้าหมายที่กระตือรือร้น

C. ภาพรวมตลาด: ผู้เล่นหลักและภูมิทัศน์การแข่งขัน

ตลาดผู้ช่วยเขียนโค้ดด้วย AI มีการแข่งขันที่ดุเดือด โดยมีส่วนแบ่งรายได้จำนวนมากมุ่งเน้นไปที่ส่วนการสร้างโค้ดและการเติมโค้ดอัตโนมัติ ซึ่งคิดเป็น 42.2% ในปี 2023 18

| เครื่องมือ | พื้นฐาน LLM หลัก | จุดแข็งหลัก | จุดเน้นระดับองค์กร |

| GitHub Copilot | OpenAI Codex/GPT Models | ความเร็ว, การผนวกรวม IDE | ความปลอดภัย, การตรวจสอบ, การควบคุม IP 12 |

| Claude 3 (Opus/Sonnet) | Anthropic Claude Models | การให้เหตุผล, คำอธิบาย, การดีบัก | การตรวจสอบโค้ด, ผลลัพธ์คุณภาพสูง, ความเป็นส่วนตัวของข้อมูล 13 |

| Amazon Q Developer | Claude Models (เข้าถึงโมเดลล่าสุด) | การผนวกรวม AWS, การสแกนความปลอดภัย, โค้ดเชิงตัวแทน | ธรรมาภิบาล IAM, การติดตามสิทธิ์การใช้งาน 16 |

| Code Llama | Meta Models (โอเพนซอร์ส) | ความโปร่งใส, การโฮสต์ด้วยตนเอง, การปรับแต่งอย่างละเอียด | แบบจำลองพื้นฐาน, คะแนน HumanEval สูง 4 |

III. เกณฑ์มาตรฐานประสิทธิภาพ: การประเมินเชิงปริมาณของความถูกต้องและคุณภาพของโค้ด

การวัดความสามารถในการเขียนโค้ดของ AI อย่างเป็นกลางนั้นต้องอาศัยการประเมินผ่านเกณฑ์มาตรฐานที่ได้มาตรฐาน แทนที่จะอาศัยเพียงประสบการณ์เชิงเรื่องเล่า

A. ความเข้าใจในเกณฑ์มาตรฐาน: วิวัฒนาการจาก HumanEval สู่ SWE-bench

- HumanEval (ความถูกต้องของฟังก์ชันพื้นฐาน): เกณฑ์นี้วัดความสามารถของ AI ในการสร้างโค้ดที่ใช้งานได้จากคำอธิบายที่เป็นภาษาธรรมชาติ (docstring) และผ่านชุดทดสอบที่กำหนดไว้ล่วงหน้า 6

- นัยสำคัญ: ให้มาตรวัดวัตถุประสงค์ที่ชัดเจนและเป็นผลลัพธ์แบบไบนารีสำหรับการวัดความสามารถในการสังเคราะห์โค้ดพื้นฐาน 6

- ข้อจำกัด: ปัจจุบัน HumanEval ถูกพิจารณาว่า “ค่อนข้างง่าย” และทดสอบเพียงแค่ “ความฉลาดเฉพาะประเภทหนึ่ง—ความสามารถในการเข้าใจคำอธิบายที่เป็นภาษาธรรมชาติและแปลเป็นโค้ดที่ใช้งานได้” 6 ซึ่งไม่ได้สะท้อนความซับซ้อนของปัญหาในโลกการพัฒนาจริง

- SWE-bench (ความซับซ้อนในโลกจริง): เกณฑ์นี้ประเมินความสามารถของ LLM ในการแก้ไขปัญหาซอฟต์แวร์ในโลกจริงที่พบใน GitHub (การแก้ไขบั๊ก, การใช้งานฟีเจอร์) 6 สิ่งนี้ต้องการความสามารถในการนำทางผ่านฐานโค้ดที่ซับซ้อน การทำความเข้าใจบริบท และการสร้างแพตช์ข้ามไฟล์ 8

- นัยสำคัญ: นี่คือเกณฑ์มาตรฐานที่สำคัญสำหรับการประเมินมูลค่าของ LLM ในสภาพแวดล้อมระดับองค์กร เนื่องจากมันวัดความสามารถในการลดหนี้ทางเทคนิคและแก้ไขปัญหาการผลิตที่เกิดขึ้นจริง

B. การวิเคราะห์เชิงเปรียบเทียบของ LLM ชั้นนำบนเกณฑ์มาตรฐานที่สำคัญ

ข้อมูลล่าสุดยืนยันช่องว่างในการแข่งขันที่สำคัญ โดยที่แบบจำลองของ Anthropic แสดงให้เห็นถึงการใช้เหตุผลเชิงตรรกะที่เหนือกว่า โดยเฉพาะอย่างยิ่งในงานที่ซับซ้อน 3

ตารางที่ I: การเปรียบเทียบประสิทธิภาพ LLM บนเกณฑ์มาตรฐานโค้ดอุตสาหกรรม

| แบบจำลอง/เครื่องมือ | จุดเน้นฟังก์ชันหลัก | HumanEval (Pass@1) | SWE-bench (อัตราการแก้ไข) | ประเด็นสำคัญ | แหล่งที่มา |

| Claude 3 Opus (หรือสูงกว่า) | การให้เหตุผลเชิงลึก, การตรวจสอบโค้ด | 84.9% (สูง) | ~72.5% (นำอย่างมาก) | เหนือกว่าในการแก้ปัญหาที่ซับซ้อนแบบหลายขั้นตอนและการแก้ไขบั๊กในโลกจริง | 3 |

| GPT-4 (ฐาน) | การสร้างทั่วไป, การดีบัก | 67.0% | N/A (เมตริกเก่า) | ประสิทธิภาพทั่วไปที่แข็งแกร่ง แต่ตามหลัง Opus ในด้านตรรกะการเขียนโค้ดดิบ | 3 |

| GPT-4.1 / GPT-5 (เชิงตัวแทน) | การดีบัก, สถาปัตยกรรม | ~90% (คาดการณ์/ระดับสูง) | 54.6% ถึง 65.0% (แข่งขันได้) | ประสิทธิภาพทั่วไปที่แข็งแกร่ง แต่ยังคงตามหลัง Claude Opus ในงานแก้ไขที่ซับซ้อน | 4 |

| Code Llama (โอเพนซอร์ส) | พื้นฐานโอเพนซอร์ส | ~67% (Python) / 53-55% (MBPP) | N/A | พื้นฐานโอเพนซอร์สที่ยอดเยี่ยม เหมาะสำหรับการปรับแต่งภายในองค์กร | 4 |

การวิเคราะห์ผลลัพธ์นี้เผยให้เห็นความสัมพันธ์ระหว่างต้นทุนและคุณภาพของประสิทธิภาพ: ข้อมูลชี้ให้เห็นว่ามีความสัมพันธ์ที่ชัดเจนระหว่างต้นทุนของระดับโมเดล (เช่น Claude Opus Max หรือคำขอพรีเมียมของ Copilot Enterprise) และประสิทธิภาพในงานที่มีมูลค่าสูงสุด (SWE-bench) 10 การจ่ายเงินสำหรับคุณภาพของ Opus ที่สูงกว่าจึงเป็นสิ่งที่มีการปรับปรุงความคุ้มค่า เนื่องจากช่วยลดเวลาในการแก้ไขบั๊กที่มีความรุนแรงสูง ซึ่งจะชดเชยค่าสมัครสมาชิกที่สูงขึ้นได้อย่างมีนัยสำคัญ

นอกจากนี้ ผลลัพธ์ของ Code Llama ที่ทำคะแนน HumanEval ได้อย่างน่าพอใจ (~67%) 4 แสดงให้เห็นว่าการสร้างโค้ดพื้นฐานกำลังกลายเป็นสินค้าโภคภัณฑ์ที่สามารถทำได้แม้ด้วยแบบจำลองโอเพนซอร์ส สิ่งนี้ย้ำให้เห็นถึงความจำเป็นสำหรับเครื่องมือเชิงพาณิชย์ที่จะต้องพิสูจน์มูลค่าของตนผ่านการผนวกรวมที่เหนือกว่า (Copilot) หรือการให้เหตุผลที่เหนือกว่า (Claude/GPT-X บน SWE-bench)

C. โค้ดคุณภาพและความเชี่ยวชาญเฉพาะด้าน (ML/Data)

- คุณภาพโค้ดที่เป็นแบบอย่าง (Idiomatic Code Quality): ทั้ง Claude และ Copilot ได้รับการฝึกฝนจากฐานโค้ดคุณภาพสูง ทำให้ได้ผลลัพธ์ที่สะอาดและสอดคล้องกันมากขึ้น อย่างไรก็ตาม Claude มักจะถูกกล่าวถึงว่าผลิตโค้ดที่มีคำอธิบายที่ดีกว่า มีเอกสารประกอบที่เหมาะสม และจัดการกรณีขอบ (edge cases) ได้ดีกว่า ซึ่งเหมาะสมกับการตรวจสอบโค้ดและการบำรุงรักษาในระยะยาว 5

- งาน ML/ข้อมูลเฉพาะทาง (PyTorch/Pandas): สำหรับวิศวกรแมชชีนเลิร์นนิง แม้ว่า LLMs จะสามารถสร้างโค้ด PyTorch ส่วนเริ่มต้นได้ แต่ตัวชี้วัดประสิทธิภาพที่แท้จริงคือความสามารถในการสร้างโค้ดที่ เพิ่มประสิทธิภาพด้านประสิทธิภาพ (performance-optimized) โดยใช้คุณสมบัติเฉพาะของเฟรมเวิร์ก เช่น การเพิ่มประสิทธิภาพดั้งเดิมของ PyTorch (เช่น Torch.compile, การหาปริมาณ GPU, Tensor Parallelism) 21 ความสำคัญของการสร้างโค้ดที่มีประสิทธิภาพจึงเป็นเกณฑ์การประเมินที่กำลังเกิดขึ้นใหม่ 20

IV. ประสบการณ์ของนักพัฒนา: การผนวกรวม ความเร็ว และความสามารถในการใช้งาน

A. ความเหนือกว่าในการผนวกรวม: GitHub Copilot และสภาวะ Flow State

GitHub Copilot ถือสถานะเป็น “แชมป์ที่ไม่มีใครโต้แย้ง” สำหรับการผนวกรวม เนื่องจากมีการฝังตัวอย่างลึกซึ้งใน IDE ยอดนิยม (VS Code, JetBrains) 1

- Flow State: ความเร็วและความทันทีของ Copilot ทำให้นักพัฒนา “อยู่ในโซน” ซึ่งเพิ่มผลผลิตในปัจจุบันสูงสุดโดยทำให้ผู้ช่วย AI “รู้สึกเหมือนเป็นส่วนหนึ่งของแป้นพิมพ์” 2 ประสบการณ์ที่ไร้แรงเสียดทานนี้เป็นข้อได้เปรียบในการแข่งขันหลักเหนือเครื่องมือสนทนาที่มีประสิทธิภาพสูงกว่าแต่บูรณาการน้อยกว่า 15

- ความเป็นเลิศของโค้ดส่วนเริ่มต้น: Copilot เก่งในการสร้างรูปแบบทั่วไปและโค้ดที่ซ้ำซากจำเจ ทำให้นักพัฒนามนุษย์มีเวลาไปมุ่งเน้นตรรกะทางธุรกิจที่ไม่ซ้ำใคร 1

B. ข้อเสนอคุณค่าที่ไม่เหมือนใครของ Claude: คำอธิบายและการสร้างต้นแบบ

แม้จะต้องมีการสลับบริบทเล็กน้อยเมื่อเทียบกับ Copilot แต่ Claude ก็มอบประโยชน์เสริม 2:

- คำอธิบายที่เหนือกว่า: จุดแข็งหลักของ Claude คือการให้คำอธิบายที่ชัดเจนและเป็นธรรมชาติของแนวคิดและอัลกอริทึมที่ซับซ้อน ทำให้เป็นเครื่องมือที่ยอดเยี่ยมสำหรับการเรียนรู้ การเริ่มต้นใช้งาน และการทำความเข้าใจฐานโค้ดเดิม 1

- การสร้างต้นแบบเชิงสร้างสรรค์ (Artifacts): คุณสมบัติ “Artifacts” นำเสนอความสามารถในการสร้างภาพและการสร้างแบบเรียลไทม์ ขยายสิ่งที่นักพัฒนาสามารถผลิตได้ โดยเฉพาะอย่างยิ่งในขั้นตอนการสร้างต้นแบบอย่างรวดเร็ว 2

- การคิดเชิงลึก: Claude เก่งในการ “คิดในรูปแบบยาว” และการให้โค้ดที่พร้อมสำหรับการผลิตพร้อมด้วยโครงสร้างที่รอบคอบและการจัดการกรณีขอบที่แข็งแกร่ง 5

C. การแลกเปลี่ยนเชิงกลยุทธ์: ความเร็วเทียบกับความลึกของการให้เหตุผล

การตัดสินใจเลือกระหว่าง Copilot และ Claude สะท้อนถึงการแลกเปลี่ยนเชิงกลยุทธ์:

| ความสำคัญของภารกิจ | เครื่องมือที่เหมาะสมที่สุด | เหตุผล |

| การพัฒนาฟีเจอร์อย่างรวดเร็ว (รูปแบบที่ทราบ) | GitHub Copilot | เน้นความเร็ว การผนวกรวม IDE และการลดการสลับบริบท |

| การดีบักปัญหาการผลิตที่ซับซ้อน | Claude 3 Opus | เน้นตรรกะเชิงลึก การให้เหตุผลแบบหลายขั้นตอน และการจัดการบั๊กที่คลุมเครือ 1 |

| การตรวจสอบโค้ดและเอกสาร | Claude 3 Opus | เหนือกว่าสำหรับคำอธิบายโค้ดที่ละเอียดถี่ถ้วนและการระบุปัญหาด้านความปลอดภัย 1 |

ตารางที่ II: การเปรียบเทียบคุณสมบัติและการผนวกรวมของเครื่องมือเขียนโค้ด AI ชั้นนำ

| คุณสมบัติ/ด้าน | GitHub Copilot | Claude 3 (Opus/Max) | Amazon Q Developer Pro |

| จุดแข็งหลัก | การเติมโค้ด, ความเร็ว, การผนวกรวม IDE | การให้เหตุผลที่ซับซ้อน, การตรวจสอบโค้ด, เอกสาร | การผนวกรวม AWS-Native, การสแกนความปลอดภัย, การแปลงโค้ด |

| การผนวกรวม IDE | ไร้รอยต่อ (VS Code, JetBrains) 1 | เข้าถึงได้ผ่าน API/ส่วนขยาย (ต้องสลับบริบท) 2 | IDE/CLI (เน้น AWS ดั้งเดิม) 17 |

| ความชำนาญในการดีบัก | ตามบริบท/การแก้ไขด่วน | เหนือกว่า (ตรรกะเชิงลึก, กรณีขอบ, การแก้ไขข้อผิดพลาด) 1 | แข็งแกร่ง (การสแกนช่องโหว่, การตรวจจับความลับที่ฮาร์ดโค้ด) 16 |

| คุณสมบัติเฉพาะ | การรักษาสภาวะ Flow State, การสร้างโค้ดส่วนเริ่มต้น | Artifacts, คำอธิบายที่เหนือกว่า, การสร้างต้นแบบเชิงสร้างสรรค์ 2 | คำขอเชิงตัวแทน, การติดตามสิทธิ์การใช้งาน/การอ้างอิง 17 |

V. ความพร้อมระดับองค์กร: ความปลอดภัย ธรรมาภิบาล และ TCO

สำหรับผู้นำด้านเทคนิค การเลือกผู้ช่วย AI เป็นการตัดสินใจด้านธรรมาภิบาลพอๆ กับการตัดสินใจด้านประสิทธิภาพ เนื่องจากความปลอดภัยของข้อมูล การปกป้องทรัพย์สินทางปัญญา (IP) และการปฏิบัติตามกฎระเบียบมีความสำคัญสูงสุด

A. ความปลอดภัยของข้อมูลและนโยบายความเป็นส่วนตัว

- GitHub Copilot (ระดับองค์กร): มีการเข้ารหัสข้อมูลทั้งในระหว่างการส่งผ่าน (TLS) และเมื่ออยู่กับที่ (มาตรฐาน FIPS Publication 140-2) 12 สิ่งที่สำคัญอย่างยิ่งคือ แผนระดับองค์กรจะป้องกันไม่ให้ข้อความแจ้ง (prompts) และข้อเสนอแนะถูกนำไปใช้สำหรับการฝึกอบรมแบบจำลองในอนาคตโดยค่าเริ่มต้น 9 นอกจากนี้ Copilot Business และ Enterprise ยังรวมอยู่ในการจัดการความปลอดภัยของข้อมูลของ GitHub ซึ่งสอดคล้องกับใบรับรอง ISO 27001 ที่อัปเดตเมื่อเดือนพฤษภาคม 2024 12

- Claude (ระดับผู้บริโภค/Pro): ให้การควบคุมผู้ใช้อย่างชัดเจน หากการสนทนาถูกลบ ข้อมูลนั้นจะไม่ถูกใช้สำหรับการฝึกอบรมแบบจำลองในอนาคต 13 ผู้ใช้สามารถเลือกที่จะไม่ให้ข้อมูลสำหรับการฝึกอบรมได้ และ Anthropic ยืนยันว่าไม่ได้ขายข้อมูลผู้ใช้ให้กับบุคคลที่สาม 13 จุดยืนความเป็นส่วนตัวที่แข็งแกร่งนี้อาจดึงดูดองค์กรที่จัดการทรัพย์สินทางปัญญาที่มีความอ่อนไหวสูง

B. การปกป้องทรัพย์สินทางปัญญา (IP) และการตรวจสอบ

ความเสี่ยงในการสร้างโค้ดที่ละเมิดลิขสิทธิ์โอเพนซอร์สจะต้องได้รับการบรรเทาอย่างเป็นระบบ

- ตัวกรองการตรวจจับการทำซ้ำ (GitHub Copilot): Copilot เสนอตัวกรองที่ผู้ดูแลระบบสามารถเปิดใช้งานเพื่อตรวจจับและระงับข้อเสนอแนะที่มีโค้ดที่ตรงกับโค้ดสาธารณะบน GitHub (ตั้งแต่ 65 lexemes หรือ 150 อักขระโดยเฉลี่ยขึ้นไป) 12 นี่คือมาตรการป้องกันที่สำคัญขององค์กรต่อการละเมิดใบอนุญาตที่อาจเกิดขึ้น

- คุณสมบัติการอ้างอิงโค้ด (Copilot และ Amazon Q): Copilot มีคุณสมบัติการอ้างอิงโค้ดเพื่อช่วยผู้ใช้ค้นหาและตรวจสอบใบอนุญาตโอเพนซอร์สที่อาจเกี่ยวข้องเมื่อเกิดการจับคู่ 12 Amazon Q Developer ก็รวมการติดตามใบอนุญาตและข้อมูลอ้างอิงด้วย 19

C. การวิเคราะห์รูปแบบการกำหนดราคาโดยละเอียด: TCO และมูลค่า

การคำนวณต้นทุนรวมในการเป็นเจ้าของ (TCO) จะต้องพิจารณาถึงการเข้าถึงคุณสมบัติ ไม่ใช่แค่ค่าธรรมเนียมการสมัครสมาชิกรายเดือน

- การเข้าถึงพลังงานแบบแบ่งระดับ (Tiered Access to Power): การย้ายไปสู่ “คำขอพรีเมียม” (Copilot Enterprise) และต้นทุนที่สูงของ Claude Max (เริ่มต้นที่ 100 ดอลลาร์ต่อเดือน) บ่งชี้ว่าการเข้าถึงแบบจำลองการให้เหตุผลที่ทรงพลังที่สุด (ซึ่งมีประสิทธิภาพดีที่สุดบน SWE-bench) มีการกำหนดราคาที่สูง 9

- ข้อควรพิจารณาด้านงบประมาณ: สำหรับนักพัฒนาเดี่ยวหรือผู้ที่ใส่ใจเรื่องงบประมาณ GitHub Copilot Pro หรือ Claude Pro ขั้นพื้นฐาน (20 ดอลลาร์ต่อเดือน) ให้คุณค่าที่สำคัญ อย่างไรก็ตาม ความได้เปรียบในการแข่งขันที่แท้จริง (Opus, ตัวแทนเฉพาะทาง) อยู่ในระดับที่มีราคาสูงกว่า 10

- Amazon Q Developer Pro: แข่งขันได้สูงที่ 19 ดอลลาร์ต่อผู้ใช้ต่อเดือน โดยนำเสนอการควบคุมระดับองค์กร คำขอเชิงตัวแทน และคุณสมบัติความปลอดภัย ทำให้เป็นที่น่าสนใจอย่างยิ่งสำหรับองค์กรที่ลงทุนอย่างหนักในระบบนิเวศของ AWS 16

ตารางที่ III: การเปรียบเทียบราคาและคุณสมบัติระดับองค์กร (ต่อผู้ใช้/เดือน)

| ระดับเครื่องมือ | ต้นทุนรายเดือน (USD) | ข้อเสนอคุณค่าหลัก | คุณสมบัติระดับองค์กรที่สำคัญ | แหล่งที่มา |

| GitHub Copilot Business | $19 | ความเร็วสูง, การผนวกรวม IDE | ISO 27001, บันทึกการตรวจสอบ, ตัวกรอง IP Duplication 9 | 9 |

| GitHub Copilot Enterprise | $39 | ความเร็วสูง + ตัวแทนขั้นสูง | อนุญาตให้ใช้คำขอพรีเมียมและแบบจำลองเฉพาะทางที่สูงขึ้น 9 | 9 |

| Claude Pro | $20 | การใช้งานที่เพิ่มขึ้น, การเข้าถึงโมเดลเพิ่มเติม (เช่น Sonnet) | ความเป็นส่วนตัวของข้อมูลที่แข็งแกร่ง/ตัวเลือกการยกเลิกการฝึกอบรม 10 | 10 |

| Claude Max (Opus) | $100+ ขึ้นไป | ความสามารถในการให้เหตุผลสูงสุด, 5-20x การใช้งาน Pro | การเข้าถึง Claude Opus (ผู้ทำคะแนน SWE-bench สูงสุด) 4 | 10 |

| Amazon Q Developer Pro | $19 | การผนวกรวม AWS, เน้นความปลอดภัย | คำขอเชิงตัวแทน, การติดตามการอ้างอิงสิทธิ์การใช้งาน, การสแกนช่องโหว่ 16 | 16 |

ความแตกต่างของราคาที่สำคัญระหว่างเครื่องมือสร้างโค้ดพื้นฐาน (Copilot Business, Amazon Q Pro ที่ประมาณ 19 ดอลลาร์) และระดับการให้เหตุผลสูงสุด (Claude Max/Opus ที่ 100 ดอลลาร์ขึ้นไป) เป็นข้อบ่งชี้ว่า ตลาดให้ความสำคัญกับความลึกของการให้เหตุผลและความถูกต้อง (ประสิทธิภาพ SWE-bench) ในระดับพรีเมียมที่สูงกว่าความเร็วในการเติมโค้ดพื้นฐานถึงห้าเท่า

อีกประเด็นที่ต้องพิจารณาคือการแบ่งส่วนตลาดตามความเสี่ยงและระบบนิเวศ: องค์กรที่อ่อนไหวต่อทรัพย์สินทางปัญญาสูงอาจเลือก Copilot หรือ Amazon Q เนื่องจากมีเครื่องมือธรรมาภิบาล IP ที่แข็งแกร่ง (ตัวกรองการทำซ้ำ, การติดตามสิทธิ์การใช้งาน) 19 ในขณะที่บริษัทที่เน้น AWS เป็นศูนย์กลางจะได้รับมูลค่าเสริมจาก Amazon Q ที่มีการผนวกรวมแบบดั้งเดิม (เช่น SageMaker, การจัดการ IAM) 19

VI. ข้อเสนอแนะเชิงกลยุทธ์: การสร้างขั้นตอนการทำงานที่เสริมด้วย AI ที่เหมาะสมที่สุด

แนวคิดของ “ดีที่สุด” ต้องถูกกำหนดใหม่โดยพิจารณาจากบทบาท งาน และลำดับความสำคัญขององค์กร

A. กลยุทธ์ AI ตามบทบาท

การปรับใช้เครื่องมือ AI ควรประสานกับบทบาทนักพัฒนาที่เฉพาะเจาะจงเพื่อเพิ่มผลตอบแทนจากการลงทุน (ROI) สูงสุด:

- นักพัฒนา Full-Stack/แอปพลิเคชัน (เน้นความเร็ว): เครื่องมือหลักควรเป็น GitHub Copilot การผนวกรวม IDE ที่ไร้รอยต่อช่วยให้มั่นใจได้ถึงความเร็วและลดภาระทางปัญญาที่เกี่ยวข้องกับการสลับบริบท 2 สิ่งนี้เพิ่มการทำงานตามปกติให้เสร็จสิ้นสูงสุด

- นักวิทยาศาสตร์ ML/ข้อมูล (เน้นประสิทธิภาพและความจำเพาะ): ใช้การผสมผสาน Copilot สำหรับโค้ดส่วนเริ่มต้นของ Pandas/scikit-learn เสริมด้วยเครื่องมือสนทนา เช่น Claude 3 Opus สำหรับการออกแบบอัลกอริทึมที่ซับซ้อน คำแนะนำในการเพิ่มประสิทธิภาพ (เช่น การใช้เทคนิค Torch.compile) 22 และการดีบักไปป์ไลน์ข้อมูลที่ซับซ้อน

- สถาปนิก/ผู้ตรวจสอบอาวุโส (เน้นคุณภาพและธรรมาภิบาล): เครื่องมือหลักควรเป็น Claude 3 Opus (หรือแบบจำลองการให้เหตุผลสูงที่เทียบเท่า) ใช้สำหรับการตรวจสอบโค้ดเชิงลึก การระบุปัญหาความปลอดภัยที่ละเอียดอ่อน การสร้างเอกสารประกอบที่ครอบคลุม และการอภิปรายเชิงสถาปัตยกรรม 1 ต้นทุนที่สูงขึ้นสามารถปรับให้เข้ากับคุณภาพที่สูงขึ้นของการตัดสินใจเชิงกลยุทธ์ได้

B. ขั้นตอนการทำงานแบบผสมผสาน: การใช้ประโยชน์จากการทำงานร่วมกัน (Copilot + Claude)

ขั้นตอนการทำงานประจำวันที่เหมาะสมที่สุดเกี่ยวข้องกับการเปลี่ยนผ่านอย่างราบรื่นระหว่างเครื่องมือทั้งสองประเภท:

- ความเร็วใน IDE (Copilot): ใช้ Copilot สำหรับการเติมโค้ดทันที การสร้างฟังก์ชัน และการเขียนตัวอย่างการทดสอบโดยตรงภายใน IDE เพื่อรักษาสภาวะ Flow State 2

- การสลับบริบทเพื่อคุณภาพ (Claude): เมื่อเผชิญกับปัญหาที่ซับซ้อน ความต้องการที่คลุมเครือ ข้อบกพร่องด้านความปลอดภัย หรือต้องการตรวจสอบคำขอพูลขนาดใหญ่ ให้ใช้ประโยชน์จากพลังการสนทนาของ Claude (ผ่านเว็บ UX หรือการผนวกรวม API) สิ่งนี้ทำให้มั่นใจได้ว่ามีการใช้การให้เหตุผลที่เข้มงวดที่สุดเมื่อความเร็วเป็นรองความถูกต้อง 5

C. สรุปและข้อเสนอแนะเชิงกลยุทธ์

ข้อเสนอแนะสุดท้ายถูกกำหนดเป็นเมทริกซ์การตัดสินใจ โดยตอกย้ำปรัชญาการใช้เครื่องมือหลายอย่าง 1

| ลำดับความสำคัญของงาน | เป้าหมายการเพิ่มประสิทธิภาพ | เครื่องมือหลักที่แนะนำ | การปรับปรุงความคุ้มค่า |

| โค้ดส่วนเริ่มต้น ความเร็ว โค้ดประจำ | ความเร็ว (Flow State) | GitHub Copilot | การผนวกรวม IDE ที่ไม่มีใครเทียบได้และการเติมเต็มที่รวดเร็ว 1 |

| การดีบักที่ซับซ้อน (เช่น บั๊กการผลิต) | ความถูกต้อง (ประสิทธิภาพ SWE-bench) | Claude 3 Opus | การให้เหตุผลที่เหนือกว่า การจัดการกรณีขอบ และคำอธิบายเชิงลึก 4 |

| การออกแบบสถาปัตยกรรม การวางแผน | การให้เหตุผลและบริบท | ChatGPT / Claude 3 Opus | เก่งในการอภิปรายเชิงนามธรรมและการสร้างชุดทดสอบ/แผนที่ครอบคลุม 1 |

| การป้องกัน IP, การผนวกรวม AWS | ธรรมาภิบาลและระบบนิเวศ | Amazon Q Developer Pro | การสแกนความปลอดภัยแบบดั้งเดิมและการติดตามการอ้างอิงสิทธิ์การใช้งาน; การควบคุมนโยบายองค์กร 16 |

| การขยายระดับองค์กร/ระบบอัตโนมัติขั้นสูง | ความสามารถเชิงตัวแทน | Copilot Enterprise / Amazon Q Pro | การเข้าถึงตัวแทน AI เฉพาะทางและการอนุญาตคำขอพรีเมียมที่สูงขึ้น 9 |

ข้อสรุป

การวิเคราะห์แสดงให้เห็นว่าผู้ช่วยเขียนโค้ดด้วย AI ไม่ใช่ผลิตภัณฑ์เดียวอีกต่อไป แต่เป็นชุดของความสามารถที่ต้องเลือกใช้ตามความเหมาะสม องค์กรต้องยอมรับว่าความสามารถในการเขียนโค้ดพื้นฐาน (วัดโดย HumanEval) กำลังกลายเป็นเรื่องธรรมดา ทำให้มูลค่าทางธุรกิจที่แท้จริงขึ้นอยู่กับเครื่องมือที่ลดความเสี่ยงที่ซับซ้อนและลดหนี้ทางเทคนิค ซึ่งวัดได้โดยประสิทธิภาพของ SWE-bench

ในอนาคต บทบาทที่สำคัญจะอยู่ที่การ จัดการตัวแทน AI ในขณะที่ตัวแทนเฉพาะทาง (Copilot Enterprise, Amazon Q) เข้ามาดูแลงานแบบหลายขั้นตอนอย่างอิสระ (เช่น การลดช่องโหว่ด้านความปลอดภัย, การแก้ไขปัญหา GitHub) บทบาทของนักพัฒนาผู้เชี่ยวชาญจะเปลี่ยนจากการเขียนโค้ดไปสู่การ กำกับดูแลและสั่งการ ตัวแทนเหล่านี้เพื่อเพิ่มผลลัพธ์ทางธุรกิจสูงสุด 9 ความชำนาญในการรวมเครื่องมือเหล่านี้อย่างมีกลยุทธ์ (Copilot เพื่อความเร็ว, Claude เพื่อความลึก) จึงกลายเป็นทักษะที่ไม่สามารถต่อรองได้สำหรับนักพัฒนาที่มีมูลค่าสูง ซึ่งส่งผลกระทบโดยตรงต่อความก้าวหน้าในอาชีพ 1 องค์กรต้องลงทุนในการฝึกอบรมเครื่องมือ AI เพื่อเพิ่มขีดความสามารถของบุคลากรให้บรรลุผลลัพธ์ที่ซับซ้อนและมีคุณภาพสูงได้อย่างมีประสิทธิภาพที่สุด

ผลงานที่อ้างอิง

- AI Coding Tools Comparison Guide 2024 – Zen van Riel, เข้าถึงเมื่อ ตุลาคม 5, 2025 https://zenvanriel.nl/ai-engineer-blog/ai-coding-tools-comparison-guide/

- Claude vs. GitHub Copilot: Which AI Coding Assistant Wins? – Arsturn, เข้าถึงเมื่อ ตุลาคม 5, 2025 https://www.arsturn.com/blog/claude-vs-github-copilot-a-developers-honest-review

- Gpt4 comparison to anthropic Opus on benchmarks – OpenAI Community Forum, เข้าถึงเมื่อ ตุลาคม 5, 2025 https://community.openai.com/t/gpt4-comparison-to-anthropic-opus-on-benchmarks/726147

- Which Code-Generation AI Model Is the Best? Here’s What You Must Know – Medium, เข้าถึงเมื่อ ตุลาคม 5, 2025 https://medium.com/@asimsultan2/which-code-generation-ai-model-is-the-best-heres-what-you-must-know-65477c9427c4

- I tested Claude vs GitHub Copilot with 5 coding prompts – Here’s my winner, เข้าถึงเมื่อ ตุลาคม 5, 2025 https://techpoint.africa/guide/claude-vs-github-copilot-for-coding/

- HumanEval — The Most Inhuman Benchmark For LLM Code Generation – Shmulik Cohen, เข้าถึงเมื่อ ตุลาคม 5, 2025 https://shmulc.medium.com/humaneval-the-most-inhuman-benchmark-for-llm-code-generation-0386826cd334

- HumanEval: When Machines Learned to Code | AI Programming Breakthrough – Runloop, เข้าถึงเมื่อ ตุลาคม 5, 2025 https://www.runloop.ai/blog/humaneval-when-machines-learned-to-code

- SWE-bench Leaderboards, เข้าถึงเมื่อ ตุลาคม 5, 2025 https://www.swebench.com/

- Choosing your enterprise’s plan for GitHub Copilot, เข้าถึงเมื่อ ตุลาคม 5, 2025 https://docs.github.com/copilot/get-started/choosing-your-enterprises-plan-for-github-copilot

- Claude, เข้าถึงเมื่อ ตุลาคม 5, 2025 https://claude.ai/

- Claude Code vs. GitHub Copilot: Ultimate AI Coder Showdown – Arsturn, เข้าถึงเมื่อ ตุลาคม 5, 2025 https://www.arsturn.com/blog/claude-code-vs-github-copilot-which-ai-is-your-coding-soulmate

- FAQ – GitHub Copilot Trust Center, เข้าถึงเมื่อ ตุลาคม 5, 2025 https://copilot.github.trust.page/faq

- Updates to Consumer Terms and Privacy Policy – Anthropic, เข้าถึงเมื่อ ตุลาคม 5, 2025 https://www.anthropic.com/news/updates-to-our-consumer-terms

- The 12 Best AI Coding Assistants in 2025 – DataCamp, เข้าถึงเมื่อ ตุลาคม 5, 2025 https://www.datacamp.com/blog/best-ai-coding-assistants

- Github Copilot vs. Claude : r/GithubCopilot – Reddit, เข้าถึงเมื่อ ตุลาคม 5, 2025 https://www.reddit.com/r/GithubCopilot/comments/1ezrjkr/github_copilot_vs_claude/

- Amazon Q Developer: Pricing, Features and Alternatives in 2025 – Superblocks, เข้าถึงเมื่อ ตุลาคม 5, 2025 https://www.superblocks.com/blog/amazon-qdeveloper-pricing

- AI for Software Development – Amazon Q Developer Pricing – AWS, เข้าถึงเมื่อ ตุลาคม 5, 2025 https://aws.amazon.com/q/developer/pricing/

- Generative AI Coding Assistants Market Size Report, 2030, เข้าถึงเมื่อ ตุลาคม 5, 2025 https://www.grandviewresearch.com/industry-analysis/generative-ai-coding-assistants-market-report

- Amazon Q Pricing – AI Assistant – AWS, เข้าถึงเมื่อ ตุลาคม 5, 2025 https://aws.amazon.com/q/pricing/

- On Evaluating the Efficiency of Source Code Generated by LLMs – arXiv, เข้าถึงเมื่อ ตุลาคม 5, 2025 https://arxiv.org/html/2404.06041v1

- Accelerating Generative AI with PyTorch: Segment Anything, Fast, เข้าถึงเมื่อ ตุลาคม 5, 2025 https://pytorch.org/blog/accelerating-generative-ai/

- Maximizing AI/ML Model Performance with PyTorch Compilation – Towards Data Science, เข้าถึงเมื่อ ตุลาคม 5, 2025 https://towardsdatascience.com/maximizing-ai-ml-model-performance-with-pytorch-compilation/

- Accelerating Generative AI with PyTorch II: GPT, Fast, เข้าถึงเมื่อ ตุลาคม 5, 2025 https://pytorch.org/blog/accelerating-generative-ai-2/

- Pipelines overview – Amazon SageMaker AI – AWS Documentation, เข้าถึงเมื่อ ตุลาคม 5, 2025 https://docs.aws.amazon.com/sagemaker/latest/dg/pipelines-overview.html