I. บทสรุปสำหรับผู้บริหาร: ข้อค้นพบสำคัญเกี่ยวกับประสิทธิภาพด้านต้นทุนและการเปิดเผย AI ระดับแนวหน้า

รายงานฉบับนี้จัดทำขึ้นเพื่อวิเคราะห์ความก้าวหน้าล่าสุดของ DeepSeek AI ซึ่งเป็นผู้เล่นสำคัญจากประเทศจีน พร้อมประเมินสถานะการใช้งานฟรี (Open-Weight Licensing) และเปรียบเทียบกับประเทศอื่นๆ ที่มีส่วนร่วมในการพัฒนาปัญญาประดิษฐ์แบบเปิด (Open-Source AI)

ข้อค้นพบสำคัญเกี่ยวกับ DeepSeek (ประเทศจีน)

DeepSeek ได้สร้างความโดดเด่นในฐานะผู้นำด้านประสิทธิภาพการประมวลผลและการขยายขนาดโมเดลขนาดใหญ่ โดยเฉพาะอย่างยิ่งในซีรีส์ V3 และ V3.1 โมเดลเหล่านี้ใช้สถาปัตยกรรมแบบ Mixture-of-Experts (MoE) ขนาด 671 พันล้านพารามิเตอร์ แต่เปิดใช้งานเพียง 37 พันล้านพารามิเตอร์ต่อโทเคน 1 ประสิทธิภาพนี้ทำให้ DeepSeek สามารถลดต้นทุนในการฝึกโมเดลระดับแนวหน้าได้อย่างน่าทึ่ง โดยคาดการณ์ค่าใช้จ่ายในการฝึกโมเดล DeepSeek-V3 เต็มรูปแบบอยู่ที่ประมาณ 5.576 ล้านดอลลาร์สหรัฐฯ 1

ในประเด็นด้านการใช้งานฟรี โมเดลน้ำหนัก (Model Weights) ของ DeepSeek-V3.1 และ V3.2-Exp ถูกเผยแพร่ภายใต้ MIT License 3 ซึ่งเป็นใบอนุญาตแบบเปิดที่ให้อิสระอย่างแท้จริงในการใช้งานและทำซ้ำเพื่อวัตถุประสงค์เชิงพาณิชย์ อย่างไรก็ตาม การเข้าถึง API สำหรับโมเดลเฉพาะทาง เช่น DeepSeek-Prover V2 และ DeepSeek-Reasoner มีการคิดราคาในอัตราที่สูงกว่าทางเลือกทั่วไปจากคู่แข่งอย่างมีนัยสำคัญ 5

ข้อค้นพบสำคัญเกี่ยวกับภูมิทัศน์โลก

การแข่งขันในปัจจุบันกำหนดโดยสองปัจจัยหลักคือทางเลือกด้านสถาปัตยกรรม (MoE vs. Dense) และกลยุทธ์การออกใบอนุญาต (Licensing Strategy) ในขณะที่ DeepSeek และ Mistral (ฝรั่งเศส) ใช้ใบอนุญาตแบบผ่อนปรน (MIT/Apache 2.0) เพื่อส่งเสริมการใช้งานอย่างแพร่หลาย โมเดลชั้นนำของสหรัฐฯ อย่าง Meta Llama 3 กลับมีการใช้ข้อจำกัดเฉพาะในการใช้งานเชิงพาณิชย์สำหรับองค์กรขนาดใหญ่ (เกิน 700 ล้านผู้ใช้ต่อเดือน) เพื่อปกป้องผลประโยชน์ทางการค้า 8 นอกจากนี้ การปรากฏตัวของโมเดลคุณภาพสูงอย่าง Falcon จากสหรัฐอาหรับเอมิเรตส์ (UAE) 10 ยังตอกย้ำถึงการเปลี่ยนผ่านเชิงภูมิรัฐศาสตร์ที่ความสามารถด้าน AI ระดับแนวหน้าไม่ได้ถูกผูกขาดอยู่กับเพียงสองประเทศมหาอำนาจเท่านั้น

II. DeepSeek AI: ความก้าวหน้าทางสถาปัตยกรรมและความเชี่ยวชาญเฉพาะทาง

II.A. โมเดล MoE ของ DeepSeek (V3/V3.1/V3.2-Exp): หัวใจสำคัญของประสิทธิภาพ

DeepSeek-V3 ถือเป็นความก้าวหน้าสำคัญในแง่ของการขยายขนาดโมเดลภาษาขนาดใหญ่ (LLMs) โดยเฉพาะอย่างยิ่งการนำสถาปัตยกรรม Mixture-of-Experts (MoE) มาใช้ 2 สถาปัตยกรรมนี้ช่วยให้ DeepSeek-V3 สามารถมีพารามิเตอร์รวมทั้งสิ้น 671 พันล้านพารามิเตอร์ แต่จะมีการเปิดใช้งานพารามิเตอร์เพียง 37 พันล้านพารามิเตอร์ต่อโทเคนเท่านั้น 1 การเปิดใช้งานที่เบาบาง (Sparse Activation) นี้เป็นปัจจัยพื้นฐานที่ช่วยลดความต้องการด้านการประมวลผลในการอนุมาน (Inference) และการฝึกอบรม ทำให้ได้โมเดลที่มีประสิทธิภาพสูงในแง่ของต้นทุน

นวัตกรรมเพื่อประสิทธิภาพการฝึกอบรม

DeepSeek-V3 ได้รวมเทคนิคที่เป็นนวัตกรรมเพื่อเพิ่มประสิทธิภาพ โดยเฉพาะอย่างยิ่งการนำ Multi-head Latent Attention (MLA) และการฝึกอบรมแบบแม่นยำผสม FP8 (FP8 mixed precision training) มาใช้ 1 เทคนิคเหล่านี้มีส่วนสำคัญในการลดการใช้หน่วยความจำ GPU และการเร่งความเร็วในการฝึกอบรม โดยเฉพาะอย่างยิ่งการร่วมออกแบบอัลกอริทึม เฟรมเวิร์ก และฮาร์ดแวร์เพื่อแก้ไขปัญหาคอขวดของการสื่อสารข้ามโหนดในการฝึกอบรมแบบ MoE 2

ความสำเร็จนี้ถูกวัดผลได้ชัดเจนจากค่าใช้จ่ายในการฝึกอบรม: การฝึกโมเดล DeepSeek-V3 ล่วงหน้า (Pre-training) บนโทเคนคุณภาพสูง 14.8 ล้านล้านโทเคน ใช้เวลาเพียง 2.788 ล้าน H800 GPU-ชั่วโมง ซึ่งเทียบเท่ากับต้นทุนโดยประมาณที่ 5.576 ล้านดอลลาร์สหรัฐฯ 1 ตัวเลขนี้เป็นตัวบ่งชี้ที่สำคัญอย่างยิ่ง เพราะแสดงให้เห็นว่าต้นทุนที่จำเป็นในการสร้างโมเดล AI ระดับแนวหน้าได้ลดลงอย่างมาก ซึ่งเป็นการท้าทายสมมติฐานเดิมเกี่ยวกับค่าใช้จ่ายในการขยายขนาด และส่งเสริมให้การวิจัย AI ขนาดใหญ่เข้าถึงได้ง่ายขึ้น

การอัปเดตโมเดลล่าสุดและบริบทขนาดยาว

DeepSeek ยังคงพัฒนาอย่างรวดเร็ว โดยมีการอัปเดตโมเดลเป็น V3.1 และปล่อยรุ่นทดลอง V3.2-Exp 11 DeepSeek-V3.1 มีการปรับปรุงที่สำคัญ รวมถึงการขยายชุดข้อมูลสำหรับการประมวลผลบริบทขนาดยาว (Long Context Extension) โดยมีการเพิ่มเฟสการขยายบริบท 32K ขึ้นถึง 10 เท่า และเฟส 128K เพิ่มขึ้น 3.3 เท่า 3 ซึ่งทำให้โมเดล V3.1 สามารถรองรับความยาวบริบทได้ถึง 128K โทเคน 3

II.B. การคิดแบบไฮบริดและโมเดลการให้เหตุผลเฉพาะทาง

DeepSeek-V3.1 ได้นำเสนอความสามารถที่โดดเด่นคือโหมดการทำงานแบบไฮบริดที่รองรับทั้ง “โหมดการคิด” (thinking mode) และ “โหมดไม่คิด” (non-thinking mode) 3 โหมดนี้เปิดใช้งานผ่านการปรับเปลี่ยน Chat Template โดยมีการเพิ่มโทเคน

</think> 3 การใช้โหมดการคิดนี้ (เช่น V3.1-Terminus) ช่วยปรับปรุงประสิทธิภาพในการใช้งานเครื่องมือ (Tool Calling) และงานของตัวแทน (Agent Tasks) ได้อย่างมีนัยสำคัญ 3

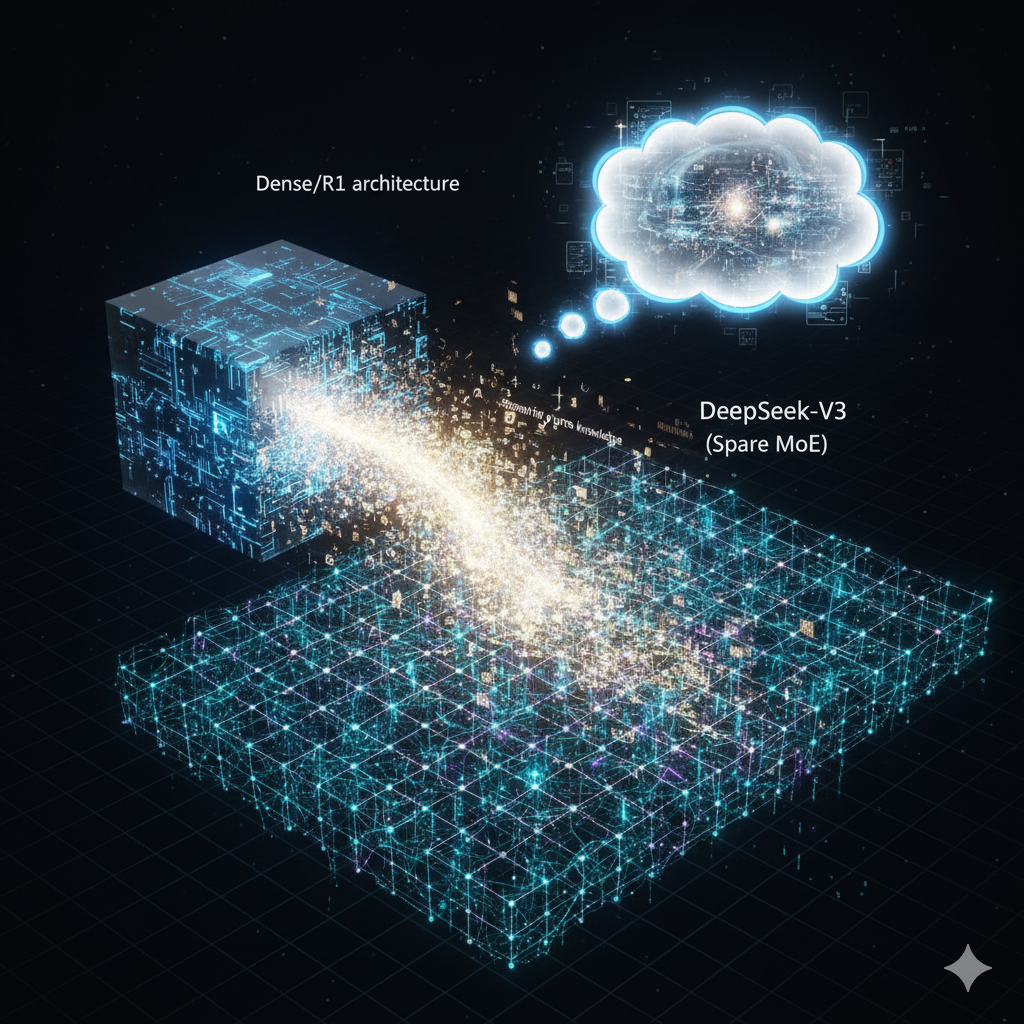

สถาปัตยกรรม Dense สำหรับความแม่นยำสูง

นอกเหนือจากสถาปัตยกรรม MoE ที่เน้นประสิทธิภาพ DeepSeek ยังพัฒนาโมเดลซีรีส์ R1 ซึ่งใช้สถาปัตยกรรมแบบ Dense 12 สถาปัตยกรรม Dense ซึ่งมีการเปิดใช้งานเต็มรูปแบบ ให้การอนุมานที่เสถียรและคาดการณ์ได้มากกว่า 12 สิ่งนี้เป็นประโยชน์อย่างยิ่งสำหรับงานที่มีความแม่นยำสูง เช่น การให้เหตุผลทางคณิตศาสตร์ การเขียนโค้ด และตรรกะ เนื่องจากสถาปัตยกรรม Dense สามารถหลีกเลี่ยงปัญหา Distribution Shift ที่อาจเกิดขึ้นในโมเดล MoE เนื่องจากการสลับผู้เชี่ยวชาญ 12

DeepSeek จึงได้นำกลยุทธ์ที่ซับซ้อนมาใช้เพื่อรวมข้อดีของทั้งสองสถาปัตยกรรม: กระบวนการ Knowledge Distillation (การกลั่นองค์ความรู้) DeepSeek ได้กลั่นกรองความสามารถในการให้เหตุผลระดับสูงของโมเดล DeepSeek R1 (Dense architecture) ซึ่งเก่งด้าน Chain-of-Thought (CoT) ไปยังโมเดล DeepSeek-V3 (MoE architecture) 2 แนวทางนี้ช่วยเพิ่มประสิทธิภาพการให้เหตุผลของ V3 อย่างเห็นได้ชัด ในขณะที่ยังคงรักษาประสิทธิภาพด้านความเร็วและต้นทุนของสถาปัตยกรรม MoE ไว้ 2

II.C. DeepSeek-Prover-V2: มุ่งเน้นไปที่การให้เหตุผลเชิงคณิตศาสตร์อย่างเป็นทางการ

DeepSeek-Prover-V2 เป็นโมเดลเฉพาะทางที่เน้นการพัฒนาความสามารถในการ ให้เหตุผลเชิงคณิตศาสตร์อย่างเป็นทางการ (Formal Mathematical Reasoning) โดยใช้เทคนิค Reinforcement Learning สำหรับการย่อยเป้าหมาย (Subgoal Decomposition) 13 การพัฒนาโมเดลนี้แสดงให้เห็นว่า DeepSeek กำลังมุ่งเน้นไปที่ขอบเขตงานที่มีความสำคัญสูงและต้องการความถูกต้องที่ตรวจสอบได้ (Verifiable AI Output) เช่น การพิสูจน์ทางคณิตศาสตร์และการเขียนโค้ดที่ซับซ้อน

ความเชี่ยวชาญเฉพาะทางนี้มีความเชื่อมโยงโดยตรงกับโครงสร้างราคาของ DeepSeek การที่ DeepSeek-Prover V2 ถูกกำหนดราคา API ที่สูงกว่าอย่างมาก 5 สะท้อนให้เห็นถึงความซับซ้อนและปริมาณทรัพยากรที่ต้องใช้ในการดำเนินการอนุมานสำหรับงานทางคณิตศาสตร์และตรรกะที่ต้องอาศัยความถูกต้องและความเสถียรสูง

ตารางที่ 1 สรุปสถาปัตยกรรมและประสิทธิภาพของโมเดล DeepSeek

| Model Variant | Architecture Type | Total Parameters | Activated Parameters | Context Length | Primary Function/Innovation |

| DeepSeek-V3/V3.1 | Mixture-of-Experts (MoE) | 671 Billion | 37 Billion | 128K | General purpose, cost efficiency (MLA, FP8) 1 |

| DeepSeek-R1 Series | Dense | N/A (Specialized) | N/A | Variable | High-precision reasoning, Distillation Source 2 |

| DeepSeek-Prover-V2 | Specialized LLM | N/A | N/A | N/A | Formal Mathematical Reasoning (via RL) 13 |

| DeepSeek-V3.1-Think | Hybrid MoE | 671 Billion | 37 Billion | 128K | Agent tasks, smarter tool calling, high thinking efficiency 3 |

III. เศรษฐศาสตร์ของ DeepSeek: ใบอนุญาต ต้นทุน และสถานะการใช้งานฟรี

III.A. การทำความเข้าใจใบอนุญาต Open-Weight (คำตอบสำหรับ “ใช้ฟรีหรือไม่”)

คำถามที่ว่า DeepSeek ยังคงใช้งานได้ฟรีหรือไม่นั้น ต้องแยกพิจารณาระหว่างการใช้งานโมเดลน้ำหนัก (Weights) โดยตรงและการใช้บริการผ่าน API

การอนุญาตแบบผ่อนปรนสำหรับ Model Weights

คำตอบโดยพื้นฐานคือ DeepSeek อนุญาตให้ใช้งานโมเดลน้ำหนักสำหรับการติดตั้งและโฮสต์ด้วยตนเองได้ฟรี DeepSeek-V3.1 และ V3.2-Exp ถูกเผยแพร่ภายใต้ MIT License 3 ซึ่งเป็นใบอนุญาตที่ถือว่าเป็น “Open-Source” ที่แท้จริงและผ่อนปรนมากที่สุด ไม่มีข้อจำกัดทางเทคนิคหรือเชิงพาณิชย์ใดๆ ในการทำซ้ำ แจกจ่าย หรือใช้งานเชิงพาณิชย์ของโมเดลเหล่านี้ 3

การเลือกใช้ MIT License เป็นการตัดสินใจเชิงกลยุทธ์ที่สำคัญ DeepSeek กำลังสร้างความแตกต่างจากแนวโน้มในอุตสาหกรรมซอฟต์แวร์ที่เปลี่ยนไปใช้ใบอนุญาตแบบจำกัดการใช้งานเชิงพาณิชย์มากขึ้น เช่น SSPL หรือ BSL (Business Source License) ซึ่งออกแบบมาเพื่อป้องกันผู้ให้บริการคลาวด์จากการนำผลิตภัณฑ์ไปเสนอบริการโดยไม่ตอบแทน 14 DeepSeek ยืนยันตำแหน่งของตนในฐานะผู้สนับสนุนการแพร่กระจายเทคโนโลยีแบบเปิดอย่างกว้างขวางทั่วโลก

อย่างไรก็ตาม แม้ว่าโมเดลน้ำหนักจะฟรี ผู้ใช้ต้องยอมรับเงื่อนไขการใช้งานทั่วไป ซึ่งรวมถึงความรับผิดชอบต่อความปลอดภัยของบัญชีและการปฏิบัติตามกฎหมายควบคุมการส่งออกและมาตรการคว่ำบาตร 15

III.B. โครงสร้างราคา API ของ DeepSeek และการแบ่งระดับบริการ

สำหรับผู้ใช้ที่ต้องการบริการที่มีการจัดการและความพร้อมใช้งานสูง DeepSeek ได้สร้างรายได้ผ่านการเข้าถึง API 7

การกำหนดราคาแบบแบ่งระดับ

DeepSeek เสนอราคาที่แตกต่างกันตามระดับความซับซ้อนของโมเดล:

- deepseek-chat (วัตถุประสงค์ทั่วไป): รองรับบริบท 64K โทเคน มีราคาสำหรับอินพุต (Cache Miss) อยู่ที่ $0.27 ต่อ 1 ล้านโทเคน และราคาเอาต์พุตอยู่ที่ $1.10 ต่อ 1 ล้านโทเคน 7

- deepseek-reasoner (การให้เหตุผลเฉพาะทาง): รองรับบริบท 64K โทเคน มีราคาสำหรับอินพุต (Cache Miss) อยู่ที่ $0.55 ต่อ 1 ล้านโทเคน และราคาเอาต์พุตอยู่ที่ $2.19 ต่อ 1 ล้านโทเคน 7

จะเห็นได้ว่าราคาเอาต์พุตของโมเดล deepseek-reasoner นั้นสูงกว่า deepseek-chat ถึงเกือบสองเท่า ($1.10 เทียบกับ $2.19) 7 การกำหนดราคาที่สูงขึ้นนี้สะท้อนให้เห็นถึงความต้องการการประมวลผลที่สูงกว่าอย่างหลีกเลี่ยงไม่ได้สำหรับงานที่ต้องอาศัยความเสถียรและความแม่นยำในการให้เหตุผลที่ได้รับการกลั่นกรองจากสถาปัตยกรรม Dense (R1) 2 DeepSeek ยังพยายามปรับปรุงต้นทุนสำหรับอินพุตซ้ำๆ โดยเสนอราคา “Cache Hit” ที่ต่ำกว่าอย่างมาก ($0.07 สำหรับ chat และ $0.14 สำหรับ reasoner) 7

III.C. การวิเคราะห์ต้นทุนเชิงเปรียบเทียบสำหรับการใช้ API

เมื่อเทียบกับคู่แข่ง DeepSeek Prover V2 ถูกจัดให้อยู่ในกลุ่มราคาพรีเมียมสำหรับการใช้งาน API:

- เทียบกับ Llama 3 70B Instruct (สหรัฐฯ): DeepSeek Prover V2 มีราคาแพงกว่าประมาณ 1.7 เท่าสำหรับโทเคนอินพุต และแพงกว่าถึง 5.5 เท่าสำหรับโทเคนเอาต์พุต ($0.50/$2.18 เทียบกับ $0.30/$0.40 ต่อ 1 ล้านโทเคน) 5

- เทียบกับ Mistral Small 3.1 (ฝรั่งเศส): ความแตกต่างด้านราคายิ่งสูงขึ้นอย่างมาก โดย DeepSeek Prover V2 แพงกว่าประมาณ 25.0 เท่าสำหรับอินพุต และ 31.1 เท่าสำหรับเอาต์พุต ($0.50/$2.18 เทียบกับ $0.02/$0.07 ต่อ 1 ล้านโทเคน) 6

ต้นทุน API ที่สูงสำหรับ DeepSeek Prover V2 ยืนยันถึงสิ่งที่แลกมา (Trade-off) ในโมเดลเฉพาะทาง: แม้ว่าสถาปัตยกรรม V3 จะลดต้นทุนในการฝึกอบรมได้อย่างยอดเยี่ยม แต่ต้นทุนในการอนุมานสำหรับงานตรรกะที่ซับซ้อนและต้องการความถูกต้องในระดับสูงก็ยังคงสูงกว่าโมเดลวัตถุประสงค์ทั่วไปหรือโมเดลที่เน้นประสิทธิภาพและความเร็วในการตอบสนอง (เช่น Mistral) อย่างมาก การตัดสินใจใช้งาน DeepSeek API จึงควรเป็นไปตามความจำเป็นสำหรับความสามารถในการให้เหตุผลที่เหนือกว่าเท่านั้น

ตารางที่ 2 การเปรียบเทียบราคา API และใบอนุญาต Open-Weight

| Model | Country of Origin | Architecture Focus | API Input Cost (Per 1M Tokens) | API Output Cost (Per 1M Tokens) | Open-Weight License | Commercial Use Restriction |

| DeepSeek-V3.1 (Weights) | China | MoE | N/A (Self-Hosted) | N/A (Self-Hosted) | MIT License | None (Permissive) 3 |

| DeepSeek-Prover V2 (API) | China | Specialized Dense/RL | $0.50 | $2.18 | N/A | API Pricing applies 5 |

| DeepSeek-Reasoner (API) | China | Specialized MoE/Dense Distilled | $0.55 (Cache Miss) | $2.19 | N/A | API Pricing applies 7 |

| Llama 3 70B Instruct (Weights) | USA | Dense | N/A (Self-Hosted) | N/A (Self-Hosted) | Custom Meta License | Restricted if >700M MAU 8 |

| Mistral Small 3.1 (API) | France (EU) | Dense/MoE | $0.02 | $0.07 | Apache 2.0 | None (Permissive) 9 |

IV. การทำแผนที่ผู้มีส่วนร่วมด้าน AI แบบเปิดทั่วโลก

นอกเหนือจาก DeepSeek ในประเทศจีน ซึ่งได้ก้าวขึ้นมาเป็นผู้เล่นสำคัญในการเผยแพร่โมเดลระดับแนวหน้าแบบเปิด (เป็นครั้งแรกนับตั้งแต่ GPT-2 ในปี 2019 ที่บริษัทจีนเปิดเผยโมเดลระดับ Frontier) 16 ยังมีประเทศและภูมิภาคอื่นๆ ที่มีส่วนร่วมอย่างแข็งขันในการพัฒนา AI แบบ Open-Weight ที่มีคุณภาพสูง

IV.A. สหรัฐอเมริกา (Meta / Llama 3): ข้อจำกัดเชิงพาณิชย์เชิงกลยุทธ์

Meta Platforms จากสหรัฐอเมริกา ได้เผยแพร่โมเดล Llama 3 ซึ่งได้รับการยอมรับอย่างกว้างขวางในด้านความสามารถในการให้เหตุผลและการรองรับภาษาที่หลากหลาย โดยมีขนาดตั้งแต่ 7 พันล้านถึง 70 พันล้านพารามิเตอร์ และ Llama 3.1 70B ได้ขยายบริบทไปถึง 128,000 โทเคน 9

กลไกการป้องกันใบอนุญาต 700M MAU

แม้ว่า Llama 3 จะถูกมองว่าเป็นโมเดล Open-Weight แต่ Meta ใช้ใบอนุญาตที่กำหนดเองซึ่งมีข้อจำกัดเชิงพาณิชย์ที่สำคัญ: องค์กรใดๆ หรือบริษัทในเครือที่มี ผู้ใช้งานต่อเดือน (Monthly Active Users – MAU) เกิน 700 ล้านคน จะต้องยื่นคำขอใบอนุญาตเฉพาะจาก Meta ซึ่ง Meta อาจอนุญาตหรือปฏิเสธก็ได้ 8

ข้อจำกัดนี้เป็นการตอบสนองเชิงกลยุทธ์ต่อแนวโน้มที่บริษัทคลาวด์ขนาดใหญ่อาจนำโมเดล AI ที่พัฒนาโดยคู่แข่งไปให้บริการโดยตรง (เช่น กรณีที่เกิดขึ้นกับการเปลี่ยนใบอนุญาตของ Elasticsearch และ MongoDB) 14 สำหรับผู้พิจารณาการใช้งานเชิงกลยุทธ์ การเลือก Llama 3 หมายถึงการรับความเสี่ยงด้านกฎหมาย หากองค์กรแม่มีผลิตภัณฑ์ที่ใกล้เคียงเกณฑ์ 700 ล้าน MAU ในอนาคต ซึ่งแตกต่างจากโมเดล DeepSeek ที่ใช้ MIT License ซึ่งไม่มีเกณฑ์ดังกล่าว

IV.B. ยุโรป (Mistral AI – ฝรั่งเศส): ประสิทธิภาพและมาตรฐานเปิด

Mistral AI ซึ่งตั้งอยู่ในประเทศฝรั่งเศส เป็นตัวแทนที่สำคัญของยุโรปในการพัฒนา AI แบบเปิด Mistral ให้ความสำคัญกับ “แนวทางที่เน้นประสิทธิภาพเป็นอันดับแรก” (Efficiency-First Approach) 9 ซึ่งมุ่งเน้นการบีบอัดเวลาตอบสนองเพื่อตอบโจทย์การใช้งานที่ต้องการความหน่วงต่ำ (Low Latency) เช่น การสนทนาแบบเรียลไทม์ 9 Mistral นำเสนอทั้งโมเดล Dense (Mistral Small 3.1) และ MoE (ซีรีส์ Mixtral) 9

ใบอนุญาต Apache 2.0 และการสนับสนุนเชิงกลยุทธ์

Mistral ใช้ Apache 2.0 License 9 ซึ่งเป็นใบอนุญาตที่ผ่อนปรนและโปร่งใสสำหรับการใช้งานเชิงพาณิชย์ การเลือกใบอนุญาตนี้ช่วยส่งเสริมความเชื่อมั่นในหมู่นักพัฒนาและองค์กรต่างๆ ทั่วโลก ในเชิงกลยุทธ์ Mistral ได้รับการระดมทุนจำนวนมาก (1.7 พันล้านยูโร) 17 และได้รับการสนับสนุนจากหน่วยงานสาธารณะและอุตสาหกรรมในยุโรป เพื่อผลักดันความก้าวหน้าตลอดห่วงโซ่มูลค่าเซมิคอนดักเตอร์และ AI ทำให้ Mistral เป็นผู้เล่นอิสระเชิงกลยุทธ์ของยุโรปที่ยึดมั่นในมาตรฐานแบบเปิด

IV.C. ตะวันออกกลาง (TII – สหรัฐอาหรับเอมิเรตส์ / Falcon): การเกิดขึ้นของศูนย์กลางภูมิภาค

Technology Innovation Institute (TII) ในสหรัฐอาหรับเอมิเรตส์ (UAE) ได้พัฒนาโมเดลตระกูล Falcon ซึ่งรวมถึง Falcon 40B และ Falcon 180B 10 Falcon 40B เคยเป็นโมเดล Open-Source ที่ติดอันดับสูงสุดของโลกเมื่อเปิดตัว 10

การเผยแพร่แบบ Royalty-Free และความสามารถหลากหลายภาษา

Falcon มีความโดดเด่นในด้านคุณภาพของชุดข้อมูล (REFINEDWEB dataset) และการฝึกอบรมที่มีประสิทธิภาพ โดยใช้พลังงานการประมวลผลเพียง 75% ของ GPT-3 10 โมเดล Falcon ถูกนำเสนอแบบ

Royalty-Free (ปลอดค่าลิขสิทธิ์) พร้อมน้ำหนักโมเดลอย่างสมบูรณ์ 10 เพื่อส่งเสริมการเข้าถึงเทคโนโลยี AI อย่างเท่าเทียม

Falcon 2 11B รุ่นล่าสุดมีการเพิ่มขีดความสามารถแบบ Multimodal (Vision-to-Language) และแสดงประสิทธิภาพทัดเทียมกับ Llama 3 8B และ Google Gemma 7B 10 ความสำเร็จของ Falcon ยืนยันว่าการพัฒนา AI ระดับแนวหน้าแบบเปิดไม่ได้จำกัดอยู่แค่ในประเทศจีนและสหรัฐอเมริกาเท่านั้น แต่ยังขยายไปยังศูนย์กลางนวัตกรรมใหม่ๆ ที่ได้รับการสนับสนุนจากรัฐบาลในภูมิภาคอื่นด้วย

V. นัยยะเชิงกลยุทธ์และข้อเสนอแนะ

V.A. การแลกเปลี่ยนทางสถาปัตยกรรมในการใช้งาน: MoE เทียบกับ Dense สำหรับองค์กร

สำหรับผู้นำด้าน R&D และการตัดสินใจทางเทคนิค การเลือกสถาปัตยกรรมต้องสอดคล้องกับวัตถุประสงค์การใช้งาน DeepSeek-V3 (MoE) ซึ่งมีต้นทุนการฝึกอบรมที่ต่ำและมีประสิทธิภาพการอนุมานต่อโทเคนสูง เหมาะสำหรับการใช้งานในวงกว้างที่ความแม่นยำทั่วไปเป็นสิ่งสำคัญที่สุด

อย่างไรก็ตาม สถาปัตยกรรม MoE อาจแสดงความไม่สม่ำเสมอในการให้เหตุผลที่ซับซ้อน 12 หากแอปพลิเคชันต้องการความเสถียรและความแม่นยำที่รับประกันได้ (เช่น การตรวจสอบทางคณิตศาสตร์อย่างเป็นทางการ หรือการให้เหตุผลทางกฎหมาย) โมเดล Dense ดั้งเดิม (เช่น DeepSeek R1 หรือ Llama 3 70B) อาจยังคงเป็นทางเลือกที่ปลอดภัยกว่า

กลยุทธ์ของ DeepSeek ในการกลั่นกรองความรู้จาก R1 (Dense) ไปยัง V3 (MoE) 2 ชี้ให้เห็นถึงความพยายามที่จะเสนอทางออกที่รวมเอาประสิทธิภาพของ MoE เข้ากับความสามารถในการให้เหตุผลขั้นสูง ทำให้ V3.1-Think เป็นทางเลือกที่น่าสนใจสำหรับงาน Agent Tasks ที่ซับซ้อนมากขึ้น 3

V.B. การประเมินความเสี่ยง: การปฏิบัติตามข้อกำหนดใบอนุญาต

ในยุคที่ใบอนุญาตซอฟต์แวร์เปิดมีการเปลี่ยนแปลงเพื่อจำกัดการใช้ประโยชน์เชิงพาณิชย์ 14 การเลือกโมเดลที่มีใบอนุญาตแบบผ่อนปรนอย่างแท้จริงถือเป็นสิ่งสำคัญสำหรับความมั่นคงในระยะยาว

- ความเสี่ยงต่ำ: DeepSeek (MIT License) และ Mistral (Apache 2.0 License) นำเสนอความชัดเจนทางกฎหมายที่สูงที่สุด เนื่องจากไม่มีข้อจำกัดด้านขนาดหรือรายได้ในการใช้งานเชิงพาณิชย์ 3

- ความเสี่ยงที่ต้องเฝ้าระวัง: องค์กรขนาดใหญ่ระดับโลกที่พิจารณาใช้ Llama 3 ต้องกำหนดมาตรการตรวจสอบอย่างต่อเนื่องเพื่อไม่ให้เกินเกณฑ์ 700 ล้าน MAU 8 การละเมิดข้อกำหนดนี้อาจนำไปสู่การยกเลิกสัญญาหรือการถูกบังคับให้ขอใบอนุญาตใหม่โดยไม่คาดคิด

V.C. แนวโน้มในอนาคต: การแข่งขันที่ขับเคลื่อนด้วยประสิทธิภาพและการแพร่กระจาย

ความสามารถของ DeepSeek ในการเข้าถึงสถานะ AI ระดับแนวหน้าด้วยต้นทุนการฝึกอบรมที่ต่ำกว่าที่คาดการณ์ไว้ (ประมาณ 5.576 ล้านดอลลาร์สหรัฐฯ) 1 แสดงให้เห็นว่าการแข่งขันในอุตสาหกรรม AI ได้เปลี่ยนจากเพียงแค่การเพิ่มขนาดไปสู่การแข่งขันด้าน

ประสิทธิภาพในการฝึกอบรมและการอนุมาน 16

การที่โมเดล Open-Weight คุณภาพสูงยังคงได้รับการเผยแพร่จากหลากหลายภูมิภาคทั่วโลก ไม่ว่าจะเป็นจีน (DeepSeek), ยุโรป (Mistral) หรือตะวันออกกลาง (Falcon) 10 ทำให้มั่นใจได้ว่าความสามารถทางเทคโนโลยีจะแพร่กระจายอย่างต่อเนื่องทั่วโลก สิ่งนี้ช่วยลดโอกาสในการผูกขาดทางเทคโนโลยีและผลักดันให้การแข่งขันในตลาดมุ่งเน้นไปที่นวัตกรรมด้านแอปพลิเคชันและโครงสร้างพื้นฐานการประมวลผลมากขึ้น 16

ผลงานที่อ้างอิง

- DeepSeek-V3 Explained: Optimizing Efficiency and Scale – ADaSci, เข้าถึงเมื่อ ตุลาคม 6, 2025 https://adasci.org/deepseek-v3-explained-optimizing-efficiency-and-scale/

- deepseek-ai/DeepSeek-V3 – Hugging Face, เข้าถึงเมื่อ ตุลาคม 6, 2025 https://huggingface.co/deepseek-ai/DeepSeek-V3

- deepseek-ai/DeepSeek-V3.1 – Hugging Face, เข้าถึงเมื่อ ตุลาคม 6, 2025 https://huggingface.co/deepseek-ai/DeepSeek-V3.1

- deepseek-ai/DeepSeek-V3.2-Exp – Hugging Face, เข้าถึงเมื่อ ตุลาคม 6, 2025 https://huggingface.co/deepseek-ai/DeepSeek-V3.2-Exp

- DeepSeek Prover V2 vs Llama 3 70B Instruct (Comparative Analysis) – Galaxy.ai, เข้าถึงเมื่อ ตุลาคม 6, 2025 https://blog.galaxy.ai/compare/deepseek-prover-v2-vs-llama-3-70b-instruct

- DeepSeek Prover V2 vs Mistral Small 3.1 24B (Comparative Analysis) – Galaxy.ai, เข้าถึงเมื่อ ตุลาคม 6, 2025 https://blog.galaxy.ai/compare/deepseek-prover-v2-vs-mistral-small-3-1-24b-instruct

- pricing-details-usd – DeepSeek API Docs, เข้าถึงเมื่อ ตุลาคม 6, 2025 https://api-docs.deepseek.com/quick_start/pricing-details-usd

- Meta Llama 3 License, เข้าถึงเมื่อ ตุลาคม 6, 2025 https://www.llama.com/llama3/license/

- Mistral vs Llama 3: Complete Comparison for Voice AI Applications – Vapi AI Blog, เข้าถึงเมื่อ ตุลาคม 6, 2025 https://vapi.ai/blog/mistral-vs-llama-3

- Falcon Models – Falcon LLM, เข้าถึงเมื่อ ตุลาคม 6, 2025 https://falconllm.tii.ae/falcon.html

- DeepSeek-V3.1 Release, เข้าถึงเมื่อ ตุลาคม 6, 2025 https://api-docs.deepseek.com/news/news250821

- Why DeepSeek-V3 and Qwen2.5-Max Choose MoE as the Core Architecture? – RiseUnion, เข้าถึงเมื่อ ตุลาคม 6, 2025 https://www.theriseunion.com/blog/DeepSeek-MoE.html

- [2504.21801] DeepSeek-Prover-V2: Advancing Formal Mathematical Reasoning via Reinforcement Learning for Subgoal Decomposition – arXiv, เข้าถึงเมื่อ ตุลาคม 6, 2025 https://arxiv.org/abs/2504.21801

- Open Source Licensing Changes and AI Development Tools Shape Programming in 2025, เข้าถึงเมื่อ ตุลาคม 6, 2025 https://zircon.tech/blog/open-source-licensing-changes-and-ai-development-tools-shape-programming-in-2025/

- DeepSeek Terms of Use, เข้าถึงเมื่อ ตุลาคม 6, 2025 https://cdn.deepseek.com/policies/en-US/deepseek-terms-of-use.html

- DeepSeek’s release of an open-weight frontier AI model, เข้าถึงเมื่อ ตุลาคม 6, 2025 https://www.iiss.org/publications/strategic-comments/2025/04/deepseeks-release-of-an-open-weight-frontier-ai-model/

- Mistral AI raises 1.7B€ to accelerate technological progress with AI, เข้าถึงเมื่อ ตุลาคม 6, 2025 https://mistral.ai/news/mistral-ai-raises-1-7-b-to-accelerate-technological-progress-with-ai

- How to support human-AI collaboration in the Intelligent Age – The World Economic Forum, เข้าถึงเมื่อ ตุลาคม 6, 2025 https://www.weforum.org/stories/2025/01/four-ways-to-enhance-human-ai-collaboration-in-the-workplace/