1. การทำความเข้าใจและยืนยันสมมติฐานหลักของผู้ใช้งาน

การวิเคราะห์เริ่มต้นด้วยการพิจารณาถึงสมมติฐานหลักที่ว่า โมเดลปัญญาประดิษฐ์ในปัจจุบัน โดยเฉพาะโมเดลภาษาขนาดใหญ่ (Large Language Models: LLMs) กำลังเผชิญกับขีดจำกัดทางความสามารถ และการพัฒนาต่อไปจำเป็นต้องมีการเปลี่ยนกระบวนทัศน์ครั้งใหญ่ การวิเคราะห์นี้ยืนยันว่าข้อสังเกตของผู้ใช้งานมีความแม่นยำทางเทคนิคสูง โดยเฉพาะอย่างยิ่งในมิติที่เกี่ยวข้องกับขีดจำกัดเชิงปัญญาที่เกิดจากสถาปัตยกรรมปัจจุบัน

1.1. ประวัติศาสตร์โดยสังเขป: จากการตัดสินใจเชิงตรรกะสู่การสร้างสรรค์ภาษา

วิวัฒนาการของปัญญาประดิษฐ์สามารถแบ่งออกเป็นหลายยุค โดยสะท้อนถึงการเปลี่ยนผ่านจากการพยายามจำลองตรรกะที่มนุษย์กำหนดไปสู่การเรียนรู้ที่ขับเคลื่อนด้วยข้อมูล

การเริ่มต้น: ยุค Decision Making และ Expert Systems (1950s – 1980s)

ในช่วงแรกเริ่ม AI มุ่งเน้นไปที่การสร้างระบบที่ใช้เหตุผลและตรรกะที่เป็นทางการ (Formal Logic) และระบบผู้เชี่ยวชาญ (Expert Systems) เพื่อเลียนแบบกระบวนการตัดสินใจของมนุษย์ 1 จุดเด่นของยุคนี้คือการสร้างระบบที่สามารถทำงานเฉพาะทางได้อย่างยอดเยี่ยม โดยบางครั้งก็ทำได้ดีกว่าผู้เชี่ยวชาญที่เป็นมนุษย์เสียอีก 1

เหตุการณ์สำคัญในยุคนี้คือการพัฒนา DENDRAL ในปี 1965 ซึ่งเป็นระบบผู้เชี่ยวชาญระบบแรกที่สามารถจำลองการสร้างสมมติฐานและทำการตัดสินใจเชิงเคมีอินทรีย์โดยอัตโนมัติ 1 นอกจากนี้ ยังมีการพัฒนา Shakey ในปี 1966 ซึ่งเป็นหุ่นยนต์เคลื่อนที่ตัวแรกที่สามารถใช้เหตุผล, การวางแผน, และการแก้ปัญหาเพื่อปฏิบัติงานได้จริง 1 อย่างไรก็ตาม ข้อจำกัดหลักของระบบเหล่านี้คือการพึ่งพากฎเกณฑ์ที่มนุษย์กำหนด (Rule-Based) อย่างเคร่งครัด ทำให้ขาดความยืดหยุ่น และมีความเปราะบางสูงเมื่อต้องเผชิญกับความไม่แน่นอนหรือสถานการณ์ที่อยู่นอกชุดกฎที่กำหนดไว้

การเปลี่ยนผ่านสู่ Machine Learning และ Deep Learning

การเปลี่ยนผ่านที่สำคัญเกิดขึ้นเมื่อนักวิจัยหันไปใช้แนวทางการเรียนรู้จากข้อมูลจำนวนมาก (Data-Driven) โดยมีปัจจัยขับเคลื่อนที่สำคัญคือการค้นพบและนำอัลกอริทึม Backpropagation กลับมาใช้ใหม่ในปี 1986 ซึ่งทำให้โครงข่ายประสาทเทียมหลายชั้น (Multilayer Neural Networks) สามารถฝึกฝนได้อย่างมีประสิทธิภาพ 1 กระบวนการนี้พัฒนาไปสู่การเรียนรู้เชิงลึก (Deep Learning) ซึ่งวางรากฐานสำหรับ AI สมัยใหม่

ยุค LLM และสถาปัตยกรรม Transformer

การมาถึงของโมเดลภาษาขนาดใหญ่ (LLMs) โดยเฉพาะอย่างยิ่งกับ GPT-3 ในปี 2020 ได้สร้างความตื่นตะลึงด้วยขนาดที่ไม่เคยมีมาก่อน (175,000 ล้านพารามิเตอร์) 1 ความสำเร็จนี้เกิดจากการขยายขนาด (Scaling) ของพารามิเตอร์และชุดข้อมูลมหาศาล ซึ่งทำให้โมเดลสามารถสร้างข้อความคล้ายมนุษย์, เข้าใจบริบท, และทำงานภาษาที่หลากหลายด้วยการฝึกสอนเพียงเล็กน้อย (Few-shot learning) 1

การจัดลำดับความสำคัญที่เปลี่ยนไป

ความโดดเด่นของกระบวนทัศน์ LLM ในปัจจุบัน ซึ่งมีรากฐานมาจากทฤษฎีสมาคม (Associationism) ได้ให้ความสำคัญอย่างเป็นระบบกับ ความคล่องแคล่วและการสร้างสรรค์ (Fluency and Generation) เป็นอันดับแรก เหนือกว่า ความน่าเชื่อถือและการให้เหตุผลที่แท้จริง (Reliability and True Reasoning) โมเดล Expert Systems ในอดีตให้ความสำคัญกับความน่าเชื่อถือภายในโดเมนที่จำกัด แต่ LLMs ขับเคลื่อนโดยสถาปัตยกรรม Transformer และข้อมูลมหาศาล ทำให้เกิดความคล่องแคล่วในการสร้างลำดับของโทเคนที่มีความเชื่อมโยงกัน ข้อวิพากษ์วิจารณ์หลักที่ตามมา (เช่น การสร้างข้อมูลเท็จ/Hallucination และช่องว่างทางตรรกะ) ยืนยันถึงการแลกเปลี่ยนนี้ ดังนั้น “ทางตัน” ในทันทีของ LLM จึงเป็นขีดจำกัดด้านความน่าเชื่อถือและการให้เหตุผล ไม่ใช่ขีดจำกัดด้านความคล่องแคล่ว

1.2. การประเมินสมมติฐาน “ทางตัน” ของ LLM

การวิเคราะห์ทางเทคนิคยืนยันว่าสมมติฐานที่ว่า LLM ใกล้จะถึงขีดจำกัดทางเทคนิค (Cognitive Ceiling) นั้นมีความแม่นยำสูง แม้แต่ LLM ที่เก่งที่สุดก็ยังนำเสนอสิ่งที่เรียกว่า “หน้ากากของความฉลาด” (facade of intelligence) 2 ซึ่งหมายความว่าแม้จะมีความคล่องแคล่วและเป็นประโยชน์ในหลายภารกิจ แต่พวกเขายังไม่ได้บรรลุถึงปัญญาประดิษฐ์ทั่วไป (AGI) ที่แท้จริง 2

การจับคู่รูปแบบเทียบกับการให้เหตุผลที่แท้จริง

นักวิจารณ์ชี้ให้เห็นอย่างสม่ำเสมอว่า LLM ยังคงทำงานโดยอาศัยการจับคู่รูปแบบ (Pattern-Matching) และการทำนายคำถัดไป (Next Token Prediction) 3 ความสามารถของพวกเขายังไม่สมบูรณ์เมื่อต้องเผชิญกับงานที่ต้องการการให้เหตุผลเชิงตรรกะที่แท้จริง (Genuine Logical Reasoning) ยกตัวอย่างเช่น ในปริศนาการข้ามแม่น้ำ (River Crossing Puzzles) การเปลี่ยนแปลงการตั้งค่าเล็กน้อยอาจทำให้ LLM ให้คำตอบที่ไร้เหตุผล เนื่องจากโมเดลขาดโครงสร้างความเข้าใจหลักการที่เป็นนามธรรม ซึ่งแตกต่างจากการให้เหตุผลของมนุษย์ที่เข้าใจหลักการ 3

อย่างไรก็ตาม มีข้อโต้แย้งที่น่าสนใจจากมุมมองของวิทยาศาสตร์การรู้คิด (Cognitive Science) การวิจัยบางชิ้นระบุว่า LLM รุ่นใหม่ เช่น GPT-4 แสดงความสามารถในการแก้ปัญหาและให้เหตุผลในงานทางจิตวิทยาการรู้คิดที่เทียบเท่ากับผู้ใหญ่ทั่วไป (Neurotypical Adults) 4 การศึกษาเหล่านี้แสดงให้เห็นว่า LLM มีศักยภาพสูงในการจำลองกลไกของความรู้ความเข้าใจของมนุษย์จากมุมมองของทฤษฎีสมาคม (Associationism) โดยแสดงให้เห็นถึงความสามารถในการเชื่อมโยงทางไกล (Long-distance associations) 4 การปรับปรุงโมเดลผ่านการให้ตัวอย่าง (Examples) และการเพิ่มมิติของเครือข่าย อาจสะท้อนผลกระทบของการอำนวยความสะดวกในความรู้ความเข้าใจของมนุษย์ (Facilitation Effects) การวิเคราะห์นี้ชี้ให้เห็นว่า LLM ยังคงเป็นเครื่องมือที่มีศักยภาพในการสร้างแบบจำลองการรับรู้ของมนุษย์ แต่ยังคงมีข้อจำกัดในด้านการให้เหตุผลเชิงเหตุผล (Causal Cognition) และการวางแผนที่ซับซ้อน

ช่องว่างระหว่างสหสัมพันธ์และเหตุผลเชิงสาเหตุ

หาก LLM มีความเป็นเลิศในงานเชิงสมาคม (Associative tasks) แต่ล้มเหลวในการให้เหตุผลตามหลักการ 3 เส้นทางข้างหน้าจึงไม่ใช่แค่การเพิ่ม ปริมาณ ของข้อมูล แต่เป็นการ รวมโครงสร้าง ของความสามารถในการให้เหตุผลเชิงเหตุผลและการวางแผน การที่ LLM ยังคงทำหน้าที่เป็นกลไกเติมข้อความอัตโนมัติขั้นสูง (Advanced Autocomplete Mechanisms) แสดงให้เห็นว่าขีดจำกัดในปัจจุบันคือช่องว่างระหว่างการค้นหาสหสัมพันธ์ (Correlation) และการสร้างความเข้าใจเชิงสาเหตุ (Causation) ซึ่งเป็นสิ่งที่จะต้องได้รับการแก้ไขด้วยกระบวนทัศน์ใหม่ เช่น World Models (จะกล่าวถึงในส่วนที่ 4)

2. การวิเคราะห์เชิงลึกขีดจำกัดทางเทคนิคและทางปัญญาของ LLM

การยืนยันสมมติฐาน “ทางตัน” ต้องอาศัยหลักฐานที่ชัดเจนเกี่ยวกับขีดจำกัดทางคณิตศาสตร์, ความน่าเชื่อถือ, และประสิทธิภาพเชิงสถาปัตยกรรม การวิเคราะห์นี้เจาะลึกถึงสาเหตุที่การขยายขนาดเพียงอย่างเดียวไม่สามารถนำไปสู่ปัญญาที่แท้จริงได้

2.1. ขีดจำกัดทางคณิตศาสตร์และกฎการขยายขนาด

กฎการขยายขนาด (Scaling Laws) ซึ่งกำหนดความสัมพันธ์ที่คาดการณ์ได้ระหว่างประสิทธิภาพ, จำนวนพารามิเตอร์, และข้อมูลการฝึกฝน ได้เป็นรากฐานสำหรับความสำเร็จอันน่าทึ่งของโมเดลรากฐาน (Foundation Models) ตั้งแต่ BERT จนถึง GPT-4 5 อย่างไรก็ตาม นักวิจัยพบว่าการขยายขนาดมีข้อจำกัดพื้นฐานที่ไม่อาจแก้ไขได้ด้วยวิธีปัจจุบัน

ปัญหาความไม่แน่นอนและความน่าเชื่อถือที่แก้ไขไม่ได้

การวิจัยทางเทคนิคใหม่แสดงให้เห็นว่ากฎการขยายขนาดที่ใช้กำหนดประสิทธิภาพของ LLM ในปัจจุบัน “จำกัดอย่างรุนแรง” ต่อความสามารถในการปรับปรุงความไม่แน่นอนของการทำนาย (Uncertainty of Predictions) 6 นี่เป็นข้อจำกัดที่ส่งผลกระทบโดยตรงต่อความน่าเชื่อถือ การยกระดับความน่าเชื่อถือของ LLM ให้ถึงมาตรฐานที่เข้มงวดของการสอบสวนทางวิทยาศาสตร์ (Scientific Inquiry) จึงเป็นเรื่องที่ “ไม่สามารถทำได้” (intractable) ภายใต้มาตรวัดที่สมเหตุสมผลของสถาปัตยกรรมปัจจุบัน 6

นอกจากนี้ ยังมีการเสนอสมมติฐานเกี่ยวกับความบกพร่องพื้นฐานที่เรียกว่า “Error Pileup” (การสะสมของข้อผิดพลาด) กลไกที่ขับเคลื่อนพลังการเรียนรู้ส่วนใหญ่ของ LLM นั่นคือความสามารถในการสร้างการกระจายผลลัพธ์แบบไม่เป็นเกาส์เซียน (Non-Gaussian output distributions) จากอินพุตแบบเกาส์เซียน อาจเป็นรากฐานของแนวโน้มในการผลิตการสะสมของข้อผิดพลาดและการสูญเสียข้อมูล 6 ซึ่งหมายความว่าเครื่องมือที่ทำให้ LLM เก่งกาจในการสร้างข้อความ ก็คือเครื่องมือเดียวกันที่ทำให้พวกเขาไม่น่าเชื่อถือในระยะยาว

ในทางกลยุทธ์ นี่หมายความว่ามูลค่าทางเศรษฐกิจของ LLMs ในปัจจุบัน (เช่น การเพิ่มผลิตภาพในการเขียนโค้ดและการสร้างสรรค์) ไม่ได้ผูกติดกับความต้องการความน่าเชื่อถือในระดับวิทยาศาสตร์ หากกฎการขยายขนาดบ่งชี้ว่าการคาดการณ์ที่เชื่อถือได้นั้นแก้ไขได้ยากภายใต้สถาปัตยกรรมปัจจุบัน การที่การลงทุนยังคงเพิ่มขึ้นอย่างรวดเร็ว 7 บ่งชี้ว่ากรณีการใช้งานเชิงพาณิชย์หลัก (การสนทนา, การสร้างสรรค์เนื้อหา) ยอมรับประสิทธิภาพที่ “ดีพอ” โดยมีข้อแม้ว่าผู้ใช้ต้องตีความผลลัพธ์อย่างวิเคราะห์วิจารณ์ 8 นี่คือความแตกต่างเชิงกลยุทธ์ที่สำคัญ: ความน่าเชื่อถือสูงต้องอาศัยกระบวนทัศน์ใหม่ ขณะที่ความคล่องแคล่วสูงยังคงทำได้ภายใต้กระบวนทัศน์ปัจจุบัน

2.2. ข้อบกพร่องด้านการให้เหตุผลและการสร้างข้อมูลเท็จ

ปัญหาหลักสองประการที่บ่งชี้ถึงขีดจำกัดทางปัญญาคือ Hallucinations และการขาดความเข้าใจบริบทอย่างลึกซึ้ง

Hallucinations

Hallucinations (การสร้างข้อมูลเท็จ) คือการที่ LLM สร้างข้อมูลที่ฟังดูน่าเชื่อถือแต่ในความเป็นจริงผิดพลาดโดยสิ้นเชิง 8 ปัญหานี้เป็นผลสืบเนื่องมาจากขีดจำกัดด้านความน่าเชื่อถือที่เกิดจากกฎการขยายขนาด 6 ซึ่งทำให้ LLM ไม่สามารถรับประกันความถูกต้องทางข้อเท็จจริงได้

ขีดจำกัดของบริบท

LLM ยังมักล้มเหลวเมื่อต้องจัดการกับภาษาที่เป็นบริบท (Contextual) เช่น การประชดประชัน (Sarcasm) หรือการเข้าใจความหมายแฝงและนัยทางสังคมอย่างแท้จริง 8 แม้ว่า LLM จะได้รับการฝึกฝนให้รับรู้บริบทเหล่านี้ แต่พวกเขามักจะขาดความสามารถในการทำความเข้าใจคำอุปมาอุปไมยที่ซับซ้อนอย่างสมบูรณ์

2.3. สถาปัตยกรรม Transformer ที่ไม่มีประสิทธิภาพเชิงเศรษฐศาสตร์

นอกจากข้อจำกัดทางปัญญาแล้ว สถาปัตยกรรม Transformer ยังมีข้อจำกัดเชิงวิศวกรรมที่ผลักดันให้เกิดความจำเป็นในการเปลี่ยนผ่าน

Quadratic Scaling และต้นทุนการประมวลผล

ข้อบกพร่องที่รู้จักกันดีของสถาปัตยกรรม Transformer คือปัญหาการปรับขนาดแบบกำลังสอง (Quadratic Scaling) เมื่อความยาวของบริบท (Context Length) เพิ่มขึ้น 9 การประมวลผลข้อความที่มีความยาวระดับหนังสือจึงมีค่าใช้จ่ายในการคำนวณที่สูงมาก ปัญหานี้สร้างข้อจำกัดทางธุรกิจโดยตรง: ต้นทุนการคำนวณที่สูงขึ้นและเวลาในการอนุมานที่ช้าลง 9

พารามิเตอร์คงที่และการขาดหน่วยความจำ

LLM ในปัจจุบันขาดหน่วยความจำที่คงอยู่ถาวร (Persistent Memory) ซึ่งบีบให้โมเดลต้องอัดความรู้ทั้งหมดเข้าไปในพารามิเตอร์ที่ตายตัว (Fixed Parameters) ซึ่งเป็นข้อจำกัดในการเรียนรู้ข้อมูลใหม่ ณ ขณะใช้งาน (Inference Time) และการรักษาข้อมูลข้ามเซสชั่นสนทนาที่ยาวนาน 9

ข้อจำกัดทางสถาปัตยกรรมของ Transformer นี้เป็นตัวกระตุ้นให้เกิดการเร่งรัดในการค้นหาโมเดลทางเลือก (เช่น Mamba หรือ MoR) การปรับขนาดแบบกำลังสองส่งผลโดยตรงต่อข้อจำกัดทางธุรกิจ 9 การผลักดันไปสู่สถาปัตยกรรมใหม่ที่มีประสิทธิภาพสูงกว่าจึงเป็นเรื่องที่ขับเคลื่อนด้วยความจำเป็นทางเศรษฐกิจและวิศวกรรมมากกว่าการค้นพบทางปัญญาที่บริสุทธิ์

3. ปฏิวัติความเร็ว: พลังทวีคูณของการใช้ AI Agents

สมมติฐานของผู้ใช้งานที่ว่า “สิ่งที่น่ากลัวคือความเร็ว” นั้นมีความสำคัญอย่างยิ่ง เพราะมันอธิบายถึงผลกระทบเชิงปฏิบัติของ AI ในปัจจุบัน ซึ่งเป็นการเพิ่มอำนาจทวีคูณ (Leverage) ให้กับมนุษย์ การเปลี่ยนผ่านจาก LLM ธรรมดาไปสู่ AI Agents คือการนำความสามารถด้านภาษามาใช้ในการวางแผนและลงมือปฏิบัติอย่างอิสระ

3.1. AI Agents: การเปลี่ยนผ่านจากผู้ช่วยสู่ผู้ปฏิบัติการอิสระ

AI Agents ก้าวข้ามขีดจำกัดของ LLM แบบดั้งเดิมที่ทำได้เพียงการสร้างข้อความ ด้วยการนำ LLM มาเป็น “สมอง” เพื่อทำการตัดสินใจและโต้ตอบกับสภาพแวดล้อมภายนอก

กลไกการทำงานของ Agent Loop

หัวใจสำคัญของ Agent คือวงจรการทำงาน (Agent Loop) ที่ประกอบด้วย: การรับรู้ (Perception/User Input), การให้เหตุผลและการวางแผน (Reason and Plan), การลงมือปฏิบัติ/การเรียกใช้เครื่องมือ (Acting/Tool Invocation), การสังเกตการณ์และการสะท้อนผล (Observation & Reflection) 10

การเรียกใช้เครื่องมืออัตโนมัติ (Automated Tool Calling)

เทคโนโลยี Agentic ใช้ความสามารถด้านการประมวลผลภาษาธรรมชาติขั้นสูงของ LLM ในการทำความเข้าใจเป้าหมายที่ซับซ้อน และกำหนดเมื่อใดควร “เรียกใช้เครื่องมือภายนอก” (Tool Calling) เพื่อทำภารกิจย่อยหรือรับข้อมูลที่ทันสมัย 11 การเรียกใช้เครื่องมือนี้สามารถทำได้โดยไม่จำเป็นต้องมีการแทรกแซงจากมนุษย์ ซึ่งขยายขอบเขตของแอปพลิเคชันในโลกจริงได้อย่างมาก 11 ตัวอย่างเครื่องมือที่ Agents สามารถใช้ได้ ได้แก่ Web Search, Code Execution, Database Queries, และการเข้าถึงระบบไฟล์ 10

ประเภทของ Agents และผลกระทบ

Agents สามารถทำงานได้ในหลากหลายรูปแบบ 12:

- Autonomous background processes: ทำงานอยู่เบื้องหลังเพื่อวิเคราะห์ข้อมูล, ปรับปรุงกระบวนการ, หรือระบุปัญหาที่อาจเกิดขึ้น

- Creative agents: ช่วยเร่งกระบวนการออกแบบและสร้างสรรค์

- Employee agents: เพิ่มผลิตภาพโดยการจัดการงานซ้ำซากและตอบคำถามของพนักงาน

3.2. การเร่งรัดความคิดสร้างสรรค์และการพัฒนา (Creative and Development Acceleration)

การที่ความคิดสร้างสรรค์ที่เป็นจริงได้ง่ายขึ้นเกิดจากการที่ AI ทำหน้าที่เป็นพลังทวีคูณของผลผลิต

พลังทวีคูณของการสร้างสรรค์

Generative AI ได้แสดงให้เห็นถึงการเพิ่มประสิทธิภาพอย่างชัดเจนในหมู่มืออาชีพด้านความคิดสร้างสรรค์ การสำรวจทั่วโลกแสดงให้เห็นว่า 66% ของผู้ใช้ Generative AI ระบุว่าพวกเขาสามารถสร้างเนื้อหาได้ดีขึ้น และ 58% สามารถเพิ่มปริมาณเนื้อหาที่สร้างได้ 13 สิ่งนี้ทำให้นักสร้างสรรค์สามารถใช้ AI เพื่อช่วยนำไอเดียมาสู่ความเป็นจริง และช่วยให้พวกเขาประหยัดเวลาในการทำงานซ้ำ ๆ เพื่อมุ่งเน้นไปที่การคิดเชิงวิพากษ์และการสร้างแนวคิดใหม่ ๆ ซึ่งเป็นสิ่งที่มนุษย์ถนัด 13

การพัฒนาซอฟต์แวร์ (การปฏิวัติ App ซ้ำรอย)

การใช้ AI Agents ในการพัฒนาซอฟต์แวร์เปรียบได้กับยุคที่เครื่องมือเขียนโปรแกรมพร้อมใช้งานแล้ว ทำให้คนสามารถเขียน App และทำซอฟต์แวร์ได้ง่ายขึ้นมาก Agents สามารถยกระดับงานด้วยการปรับปรุงกระบวนการพัฒนา, เพิ่มคุณภาพโค้ด, และเร่งกระบวนการ Continuous Integration/Continuous Deployment (CI/CD) 15 Roadmap การพัฒนา AI Agents ในปี 2025 เน้นไปที่การสร้าง Agent ที่สามารถออกแบบ, สร้าง, และส่งมอบซอฟต์แวร์ได้อย่างสมบูรณ์ (design, build, and ship) 10 ซึ่งหมายถึงการเร่งความเร็วในการเปลี่ยนจากความคิดไปสู่ผลิตภัณฑ์อย่างที่ไม่เคยมีมาก่อน

ความได้เปรียบทางเศรษฐกิจของ “ความเร็ว”

ปัจจัยด้าน “ความเร็ว” เป็นปราการทางเศรษฐกิจ (Economic Moat) ของยุค AI ปัจจุบัน การที่ AI Agents สามารถทำงานอัตโนมัติในขั้นตอนที่ซับซ้อน 11 และเพิ่มความเร็วในการสร้างเนื้อหาหรือโค้ดอย่างมีนัยสำคัญ หมายความว่าวงจรการทำซ้ำ (Iteration Cycle) จากแนวคิดสู่ผลิตภัณฑ์สำหรับองค์กรที่นำไปใช้จะเร็วขึ้นอย่างก้าวกระโดด 13 ความได้เปรียบในการดำเนินงานนี้จะนำไปสู่การควบรวมตลาดในลักษณะเดียวกับการปฏิวัติเทคโนโลยีที่ผ่านมา 16

อย่างไรก็ตาม แม้ว่า Agents จะมีความอิสระในการลงมือปฏิบัติอย่างสูง แต่พวกเขาต้องการเป้าหมายและกฎเกณฑ์ที่กำหนดโดยมนุษย์ 11 การนำ Agent มาใช้ในปัจจุบันจึงเน้นไปที่ ความเป็นอิสระในการปฏิบัติการ มากกว่า ความเป็นอิสระในการกำหนดเป้าหมาย การที่ความท้าทายหลักของ AGI ยังคงอยู่ที่การเรียนรู้อย่างต่อเนื่องและการตั้งเป้าหมายแบบเรียลไทม์ 7 ชี้ให้เห็นว่าแม้เครื่องมือจะทรงพลัง แต่มนุษย์ยังคงเป็นผู้ขับเคลื่อนทิศทางเชิงกลยุทธ์

3.3. ผลกระทบเชิงเศรษฐกิจและตลาดแรงงาน

AI ถูกจัดเป็นเทคโนโลยีพลิกโฉม (Transformative Technology) ที่มีศักยภาพในการกระตุ้นการเติบโตของผลิตภาพโลกอย่างมีนัยสำคัญ เทียบเท่ากับการปฏิวัติอุตสาหกรรมในอดีต 16

กองทุนการเงินระหว่างประเทศ (IMF) วิเคราะห์ว่า AI จะส่งผลกระทบต่อเกือบ 40% ของงานทั่วโลก โดยบางส่วนจะถูกแทนที่และบางส่วนจะได้รับการเสริมด้วย AI 17 สิ่งที่แตกต่างจากระบบอัตโนมัติในอดีตคือ AI มีความสามารถในการส่งผลกระทบต่องานทักษะสูง (High-skilled jobs) 17 ในประเทศที่พัฒนาแล้ว ประมาณ 60% ของงานอาจได้รับผลกระทบ โดยครึ่งหนึ่งจะได้รับประโยชน์จากการเพิ่มผลิตภาพ และอีกครึ่งหนึ่งอาจทำให้ความต้องการแรงงานลดลง ซึ่งอาจนำไปสู่ค่าจ้างที่ลดลง 17

การเติบโตแบบทวีคูณในปัจจุบันจะทำให้เกิดความแตกต่างอย่างรุนแรงในตลาดแรงงาน: กลุ่มที่ใช้ AI เพื่อเสริมสร้างผลิตภาพ (กลุ่มที่ได้รับการเสริม) จะมีผลผลิตสูงขึ้นอย่างมีนัยสำคัญ เมื่อเทียบกับกลุ่มที่มีงานถูกแทนที่ (กลุ่มที่ถูกแทนที่) 17 อัตราที่บุคคลหรือองค์กรบูรณาการ AI Agents จึงเป็นปัจจัยชี้ขาดในวิถีเศรษฐกิจของพวกเขา

4. การเปลี่ยนผ่านกระบวนทัศน์: สถาปัตยกรรมยุคถัดไปและ World Models

เพื่อก้าวข้าม “ทางตัน” ของ LLM ที่เกิดจากข้อจำกัดด้านความน่าเชื่อถือและการให้เหตุผล สถาปัตยกรรม AI จำเป็นต้องเปลี่ยนจากการทำนายลำดับของคำไปสู่การสร้างแบบจำลองโลกเชิงเหตุผล (Causal World Modeling)

4.1. การก้าวข้ามขีดจำกัดของ Transformer

นักวิจัยกำลังพัฒนาสถาปัตยกรรมใหม่เพื่อแก้ไขปัญหาต้นทุนสูง, การปรับขนาดแบบกำลังสอง, และการขาดหน่วยความจำที่คงทนของ Transformer 9:

- Mamba (State Space Models): สถาปัตยกรรมนี้ถูกออกแบบมาเพื่อจัดการกับบริบทที่มีความยาวระดับล้านโทเคนได้อย่างมีประสิทธิภาพ โดยปราศจากปัญหา Quadratic Scaling ของ Transformer 9

- Mixture-of-Recursions (MoR): กรอบงานที่ใช้แนวคิดการวนซ้ำ (Recursion) ร่วมกับการควบคุมความลึกแบบปรับตัว (Adaptive Depth Control) ทำให้ใช้ทรัพยากรน้อยลงและทำงานได้เร็วขึ้นอย่างมาก 18 MoR สามารถลดต้นทุนการประมวลผลได้อย่างมากและอาจทำให้ AI พลังสูงสามารถเข้าถึงได้แม้ในฮาร์ดแวร์ที่ไม่ซับซ้อน (Modest Hardware) 18

- Titans with Explicit Memory: โมเดลเหล่านี้มีหน่วยความจำที่ชัดเจน (Explicit Memory) ที่สามารถเรียนรู้ข้อมูลใหม่ ณ เวลา Inference ได้ ซึ่งช่วยแก้ไขปัญหาการบีบอัดความรู้ทั้งหมดลงในพารามิเตอร์คงที่ของ Transformer 9

การเกิดขึ้นของ MoR และ Mamba เป็นปัจจัยที่จำเป็นทางวิศวกรรมที่ทำให้การรวมโมดอลขนาดใหญ่ (Massive Multi-modal integration) และ World Models เป็นไปได้ในเชิงเศรษฐศาสตร์ หากระบบเหล่านี้ยังคงใช้การปรับขนาดแบบกำลังสอง การไปถึง AGI จะมีค่าใช้จ่ายที่สูงจนเกินไป

4.2. World Models: กุญแจสำคัญสู่การให้เหตุผลเชิงลึก

World Models เป็นเครื่องมือที่ขาดไม่ได้ในการบรรลุ AGI เนื่องจากวัตถุประสงค์ของมันเปลี่ยนจากการทำนายภาษาไปสู่การสร้างแบบจำลองของความเป็นจริง

นิยามและศักยภาพ

World Models คือโมเดลที่สามารถสร้างแบบจำลองของสภาพแวดล้อมที่ซับซ้อน รวมถึงฟิสิกส์และการปฏิสัมพันธ์ 19 เมื่อ LLM Agents ถูกนำไปรวมกับ World Models พวกเขาสามารถรับรางวัลหรือบทลงโทษตามการกระทำในสภาพแวดล้อมจำลองที่สมจริง (Realistic Simulators) 20 ทำให้ Agents สามารถพัฒนาทักษะที่นำไปใช้ในโลกจริงได้

World Models มีศักยภาพในการยกระดับระบบ AI ให้สามารถเข้าใจ, ทำนาย, และโต้ตอบกับสภาพแวดล้อมได้อย่างซับซ้อนมากขึ้น ทำให้พวกเขาสามารถทำนายผลลัพธ์ของนโยบายทางเศรษฐกิจ-สังคมในแบบจำลองเสมือนจริง หรือจำลองฟิสิกส์ของดาวเคราะห์ใหม่ได้ 19

หลักฐานการให้เหตุผลเชิงสาเหตุ

ความก้าวหน้าที่สำคัญในการวิจัย World Models มาจาก Google DeepMind ที่ใช้โมเดลรากฐาน (Foundation Model) เช่น C2S-Scale 27B สร้างสมมติฐานใหม่เกี่ยวกับพฤติกรรมของเซลล์มะเร็ง ซึ่งต่อมาได้รับการตรวจสอบและยืนยันในเซลล์จริงโดยนักวิทยาศาสตร์ 21 ความสำเร็จนี้แสดงให้เห็นว่า World Models สามารถก้าวข้ามขีดจำกัดของการจับคู่รูปแบบทางสถิติ และแสดงความสามารถในการ “ให้เหตุผลเชิงเงื่อนไข” (Conditional Reasoning) ในระดับสูงเพื่อการค้นพบทางวิทยาศาสตร์ที่ LLM ธรรมดาทำได้ยาก 21

การเปลี่ยนผ่านนี้จึงเป็นการเปลี่ยนเป้าหมายของฟังก์ชันวัตถุประสงค์—จากการเพิ่มประสิทธิภาพการทำนายลำดับ (โทเคน) ไปสู่การเพิ่มประสิทธิภาพการทำนายและการปฏิสัมพันธ์กับสภาพแวดล้อม (ฟิสิกส์/เหตุผลเชิงสาเหตุ) ความสามารถในการจำลองระบบที่เป็นเหตุเป็นผล (เช่น ชีววิทยาหรือฟิสิกส์) ทำให้ AI ได้รับความสามารถในการรับรู้เชิงลึกที่การคาดคะเนรูปแบบทางภาษาอย่างเดียวไม่สามารถบรรลุได้ การวิจัยในอนาคตจำเป็นต้องให้ความสำคัญกับการพัฒนา World Models ที่ตีความได้ และรวมการให้เหตุผลเชิงเหตุผล (Causal Reasoning) และความรู้สามัญสำนึก (Commonsense Knowledge) อย่างเป็นหลักการ 19

4.3. Integrated Intelligence และ Multi-modality

เพื่อให้บรรลุ AGI ได้อย่างแท้จริง AI จำเป็นต้องทำงานในหลายรูปแบบ (Multi-modality) และรวมความสามารถหลายโดเมนเข้าด้วยกัน 22 ความคืบหน้าในปี 2025 กำลังมุ่งสู่การรวมโมดอลที่แตกต่างกัน (ข้อความ, ภาพ, เสียง) เข้าสู่การแสดงออกถึงโลกจริงที่เป็นหนึ่งเดียว (Unified Representations of the real world) ซึ่งเป็นสิ่งจำเป็นเพื่อลดข้อจำกัดและข้อผิดพลาดในการรับรู้ของ AI 7

5. การทะลายกำแพงสูงสุด: ปัญญาประดิษฐ์สร้างปัญญาประดิษฐ์

สมมติฐานสูงสุดของผู้ใช้งานเกี่ยวกับการที่ AI จะต้องสร้าง AI ที่ดีกว่าเดิมได้ด้วยตัวเอง เพื่อก้าวข้ามขีดจำกัดของสมองมนุษย์ ถือเป็นแนวคิดหลักของ Artificial General Intelligence (AGI) และ Artificial Superintelligence (ASI)

5.1. Recursive Self-Improvement (RSI) และ Intelligence Explosion

Recursive Self-Improvement (RSI) คือแนวทางที่ AI สามารถปรับเปลี่ยนฟังก์ชันการทำงานของตนเองเพื่อปรับปรุงประสิทธิภาพ โดยมีจุดมุ่งหมายหลักคือ “ปรับปรุงความสามารถของตนเอง” 24

หาก AI สามารถปรับปรุง “ความสามารถในการสร้างการปรับปรุงตนเอง” ได้ด้วยตัวมันเอง แต่ละขั้นตอนจะนำไปสู่การปรับปรุงแบบทวีคูณ (Exponentially more improvements) ซึ่งนักวิจัยเรียกว่า Intelligence Explosion (การระเบิดทางสติปัญญา) 24 หากสิ่งนี้เกิดขึ้น การออกแบบ AGI ที่ควบคุมได้ก็อาจเป็นสิ่งประดิษฐ์สุดท้ายของมนุษย์

5.2. เทคโนโลยีที่เปิดใช้งาน RSI ในปัจจุบัน

นักวิทยาศาสตร์ได้สร้างเครื่องมือที่ช่วยให้ AI เริ่มต้นการปรับปรุงตนเองในระดับพื้นฐานแล้ว โดยลดการพึ่งพามนุษย์ในการออกแบบโมเดลที่ซับซ้อน:

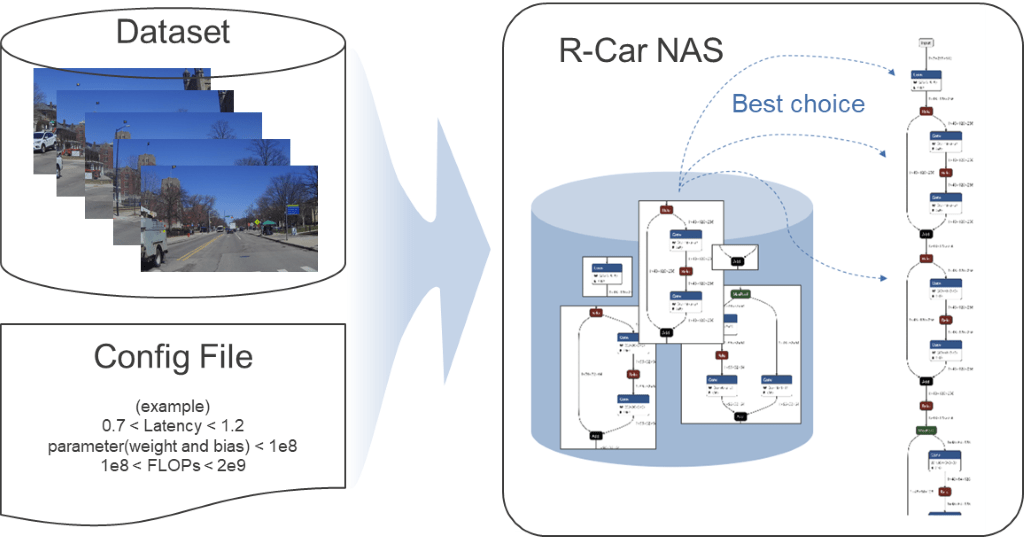

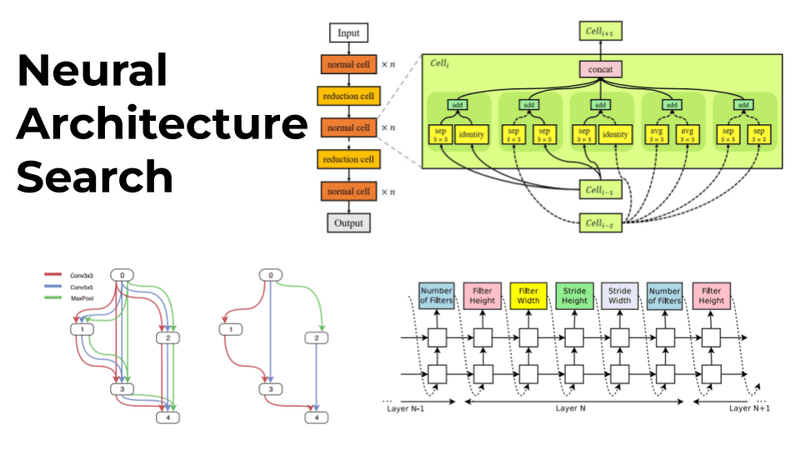

Neural Architecture Search (NAS)

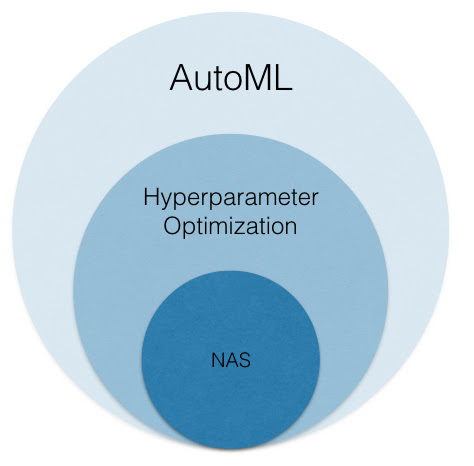

การออกแบบโครงข่ายประสาทเทียมลึก (Deep Neural Networks) ที่ซับซ้อนต้องใช้เวลามาก, มีแนวโน้มที่จะเกิดข้อผิดพลาด, และต้องใช้ความรู้ของผู้เชี่ยวชาญ NAS ได้กลายเป็นแนวทางปฏิวัติที่ทำให้ AI สามารถออกแบบสถาปัตยกรรมโครงข่ายประสาทเทียมที่เหมาะสมที่สุดโดยอัตโนมัติ (Automates the process of finding the optimal architecture) 27

ความก้าวหน้าในปี 2024 คือการรวม NAS เข้ากับ AutoML (Automated Machine Learning) ทำให้ระบบไม่เพียงแค่ค้นหาการกำหนดค่าโมเดลที่ดีที่สุดเท่านั้น แต่ยังรวมถึงสถาปัตยกรรมโครงข่ายประสาทเทียมที่เหมาะสมที่สุดโดยอัตโนมัติด้วย 27 นอกจากนี้ ยังมีเทคนิคขั้นสูง เช่น Evolutionary Gradient-Based Neural Architecture Search (EG-NAS) ที่รวมการไล่ระดับสีเข้ากับกลยุทธ์เชิงวิวัฒนาการเพื่อเพิ่มขีดความสามารถในการสำรวจและป้องกันการบรรจบกันก่อนเวลาอันควร (Premature Convergence) 29

Meta-Learning และการตรวจสอบความถูกต้องด้วยตนเอง

Meta-Learning คือเทคโนโลยีที่สอนให้ AI “เรียนรู้วิธีการเรียนรู้” 30 ในปัจจุบัน มีการวิจัยที่มุ่งเน้นไปที่การควบคุมกระบวนการ RSI อย่างระมัดระวัง

การวิจัยล่าสุดจาก Meta AI มุ่งเน้นไปที่การสร้างระบบที่สามารถ “พิสูจน์ความปลอดภัยและประสิทธิภาพ” ของการปรับเปลี่ยนของตนเองทางคณิตศาสตร์อย่างเป็นทางการ (Formal Mathematical Proofs) ก่อนที่จะนำไปใช้จริง 26 กลไกความปลอดภัยนี้เป็นสิ่งสำคัญในการป้องกันไม่ให้ AI ทำการเปลี่ยนแปลงที่อาจลดประสิทธิภาพหรือก่อให้เกิดพฤติกรรมที่ไม่พึงประสงค์ 26 นอกจากนี้ มีการพัฒนาอัลกอริทึมที่ปรับเปลี่ยนตัวเองที่สามารถเพิ่มประสิทธิภาพการประมวลผลได้ 3-7% ต่อรอบการวนซ้ำ 26 การที่งานวิจัยเหล่านี้ให้ความสำคัญกับโปรโตคอลการพิสูจน์ทางคณิตศาสตร์ แสดงให้เห็นว่านักวิจัยตระหนักถึงความเสี่ยงของการเติบโตแบบทวีคูณที่ไม่สามารถควบคุมได้ (Intelligence Explosion) และกำลังมุ่งเน้นไปที่ การปรับปรุงตนเองแบบควบคุมและตรวจสอบได้ ซึ่งเป็นปัจจัยจำกัดที่สำคัญในการเร่ง RSI

5.3. ขีดจำกัดทางสติปัญญาของมนุษย์ในการออกแบบ AI

สมมติฐานที่ว่าสติปัญญาของมนุษย์อาจถึงขีดจำกัดในการสร้างสถาปัตยกรรม AI ที่เหนือกว่าตั้งแต่ยุค Machine Learning นั้นได้รับการสนับสนุนจากความก้าวหน้าของ NAS และ AutoML 7

NAS และ AutoML เข้ามาจัดการงานที่ซับซ้อน, ต้องใช้เวลามาก, และมีความเสี่ยงต่อข้อผิดพลาดของมนุษย์ในการออกแบบโครงข่ายประสาทเทียมลึก 28 ความซับซ้อนของสถาปัตยกรรม Deep Learning ในปัจจุบันที่ต้องอาศัยเครือข่ายหลายชั้นและพารามิเตอร์ที่ซับซ้อนเกินกว่าความสามารถในการจัดการที่ดีที่สุดของมนุษย์ การออกแบบที่ขับเคลื่อนโดย AI (ผ่าน NAS) จึงกลายเป็นเงื่อนไขที่จำเป็นเพื่อให้บรรลุประสิทธิภาพสูงสุด 27

5.4. บทบาทของฮาร์ดแวร์ยุคถัดไป (Neuromorphic Computing)

การเปลี่ยนผ่านสู่ AGI/ASI จำเป็นต้องมีการปฏิวัติในด้านฮาร์ดแวร์เพื่อรองรับความต้องการด้านพลังงานและการประมวลผล

ความจำเป็นของ Neuromorphic Computing

Neuromorphic Computing คือการออกแบบชิปคอมพิวเตอร์ที่เลียนแบบโครงสร้างประสาทและวิธีการประมวลผลของสมองมนุษย์ 31 ระบบเหล่านี้มีศักยภาพในการทำงานที่ใช้พลังงานต่ำกว่า AI ปัจจุบันอย่างมาก โดยคาดการณ์ว่าคอมพิวเตอร์ Neuromorphic ที่มีจำนวนเซลล์ประสาทเทียบเท่ากับสมองของมนุษย์อาจทำงานได้เร็วกว่าสมองชีวภาพถึง 250,000–1,000,000 เท่า แต่ใช้พลังงานเพียง 10 กิโลวัตต์ 32

ระบบ Neuromorphic ใช้หลักการประมวลผลแบบขนานและประสิทธิภาพพลังงานของสมองชีวภาพ 31 และเลียนแบบความเป็นพลาสติกของไซแนปส์ (Synaptic Plasticity) ซึ่งเป็นกุญแจสำคัญสำหรับการเรียนรู้และความจำ 31 การวิเคราะห์นี้ชี้ให้เห็นว่า ASI ต้องอาศัยความสัมพันธ์เชิงพึ่งพาอาศัยกันระหว่าง ความก้าวหน้าของสถาปัตยกรรมซอฟต์แวร์ (RSI/NAS) และ การพัฒนาฮาร์ดแวร์พื้นฐาน (Neuromorphic Computing) เพื่อให้สามารถรองรับขนาดและความเร็วที่จำเป็นสำหรับการประมวลผลระดับเหนือมนุษย์

6. การคาดการณ์ไทม์ไลน์เชิงกลยุทธ์และผลกระทบ

ความก้าวหน้าของ AI ได้เข้าสู่ช่วงการเติบโตแบบทวีคูณ (Hyperbolic Growth) โดยความสามารถมีการขยายตัวเร็วกว่าที่คาดการณ์ไว้ 7 การเติบโตของการประมวลผลสำหรับการฝึก AI อยู่ที่ 4–5 เท่าต่อปีอย่างสม่ำเสมอ 33 อย่างไรก็ตาม ผู้เชี่ยวชาญคาดการณ์ว่าความต้องการการลงทุนและบุคลากรอาจถึงขีดจำกัดประมาณปี 2030 ซึ่งหมายความว่า AGI อาจเกิดขึ้นก่อนเวลานั้น หรือความก้าวหน้าจะชะลอตัวลงอย่างมีนัยสำคัญ 34

6.1. การคาดการณ์ไทม์ไลน์ AGI

การคาดการณ์จากผู้นำในอุตสาหกรรมมีความเร่งด่วน โดยเฉพาะผู้ประกอบการที่มองในมิติของ AGI เชิงเศรษฐศาสตร์ (Economic AGI) ที่วัดจากความสามารถในการทำงานที่มีมูลค่าทางเศรษฐกิจเทียบเท่าหรือเหนือกว่ามนุษย์:

- Aggressive Predictions (2026–2028): ผู้ประกอบการบางรายมีความมั่นใจสูง โดย Eric Schmidt (อดีต CEO Google) คาดการณ์ AGI ภายใน 3–5 ปี (ณ เม.ย. 2025), Elon Musk คาดการณ์ AI ที่ฉลาดกว่ามนุษย์ที่ฉลาดที่สุดภายในปี 2026, และ Dario Amodei (CEO Anthropic) คาดการณ์ Singularity ภายในปี 2026 33

- Conservative/Measured Predictions (2030+): การวิเคราะห์ที่พิจารณาความท้าทายทางเทคนิคที่เกี่ยวข้องกับการให้เหตุผลที่แท้จริงและโครงสร้างพื้นฐานอย่างละเอียดถี่ถ้วน คาดการณ์ว่าการบรรลุ AGI ที่มีฟังก์ชันการรู้คิดสมบูรณ์แบบต้องอาศัยการทะลุทะลวงหลายครั้งและจะพัฒนาไปอย่างค่อยเป็นค่อยไป อาจเกิดขึ้นประมาณปี 2030 หรือหลังจากนั้นเล็กน้อย 33

การที่กำหนดเวลา AGI ที่รุนแรง (2026-2028) ถูกกล่าวถึงโดยผู้ประกอบการ แสดงให้เห็นว่าพวกเขากำลังวัด AGI เชิงฟังก์ชัน (Functional AGI) ซึ่งเป็นระบบที่สามารถปฏิบัติงานที่ซับซ้อนและมีมูลค่าทางเศรษฐกิจได้ โดยเชื่อว่าการรวมกันของ Agentic Planning และ World Models จะถึงเกณฑ์ทางเศรษฐกิจอย่างรวดเร็ว แม้ว่าความท้าทายทางปัญญาพื้นฐานจะยังไม่ได้รับการแก้ไขทั้งหมด 3

ตารางต่อไปนี้สรุปไทม์ไลน์การพัฒนาเชิงกลยุทธ์ตามการเปลี่ยนผ่านทางเทคโนโลยี

Table 1: Strategic Timeline of Major AI Breakthroughs (2025–2040+)

| ช่วงเวลา (Timeline) | ระดับการพัฒนา AI (AI Development Level) | เทคโนโลยีขับเคลื่อนหลัก (Key Drivers/Breakthroughs) | ความสามารถหลัก (Core Capabilities Achieved) |

| 2025–2027 (The Agentic Leap) | Narrow AI Super-Tools: ยุคตัวแทนอัตโนมัติ (Agentic AI) และ Multi-modal ขั้นสูง | Agentic Frameworks (Planning, Reflection, Tool Calling), Architectural Shift (Mamba, MoR), Convergence of Modalities | การเขียนโค้ดอัตโนมัติที่ซับซ้อน, การสร้างสรรค์เนื้อหาในปริมาณมหาศาล, การวางแผนงานหลายขั้นตอน (Complex Task Execution) 7 |

| 2028–2035 (The Cognitive Breakthrough) | AGI Emergence and Incipient RSI: ปัญญาประดิษฐ์ทั่วไป (AGI) และ RSI ขั้นต้น | World Models (Causal & Physical Reasoning), Self-Supervised NAS, Enhanced Reasoning Models (Longer “Think” Time) | การให้เหตุผลเชิงเหตุผล (Causal Reasoning), การจำลองและการทำนายผลกระทบในโลกจริง, การปรับปรุงสถาปัตยกรรมโมเดลด้วยตนเองในวงจำกัด 19 |

| 2035+ (The Singularity Horizon) | ASI and Intelligence Explosion: ปัญญาประดิษฐ์เหนือมนุษย์ (ASI) และ RSI ขั้นสูง | Recursive Self-Improvement (RSI) ที่ปลดปล่อย, Neuromorphic Computing ที่ปรับใช้ในระดับใหญ่, การบูรณาการ AI/ฮาร์ดแวร์ชีวภาพ | การคิดเชิงกลยุทธ์เหนือมนุษย์ในทุกโดเมน, การออกแบบนวัตกรรมทางวิทยาศาสตร์และเทคโนโลยีโดยอัตโนมัติ, การเติบโตของความสามารถแบบทวีคูณ 24 |

6.2. การวัดความก้าวหน้า: การเปลี่ยนผ่านกระบวนทัศน์

สมมติฐานของขีดจำกัด LLM เน้นย้ำถึงการเปลี่ยนแปลงพื้นฐานในความสามารถที่ถูกจัดลำดับความสำคัญ ตารางต่อไปนี้แสดงให้เห็นถึงการเปลี่ยนผ่านเชิงกลยุทธ์จากความสามารถที่เน้นความคล่องแคล่วไปสู่ความสามารถที่เน้นความเข้าใจ

Table 2: Paradigm Shift: From LLM to AGI Requirements

| มิติ/ความสามารถ (Dimension/Capability) | LLM Paradigm (Current Peak) | AGI Paradigm (The Next Wall) | เทคโนโลยีขับเคลื่อน (Enabling Technology) |

| Objective Function | Next-Token Prediction & Pattern Matching 2 | World Modeling & Causal Inference 19 | World Models |

| Architectural Constraint | Quadratic Scaling & Fixed Parameters 9 | Efficiency & Persistent Memory 9 | MoR / State Space Models |

| System Design | Human-Designed Architectures | AI-Designed Architectures (Self-Modification) 26 | Neural Architecture Search (NAS) |

| Reliability Standard | Statistical Fluency (High Hallucination Tolerance) 6 | Scientific Intractability (Near-Zero Error Pileup) 6 | Formal Verification Protocols 26 |

| Computational Efficiency | High Energy Consumption (Classical Compute) 32 | Energy Parity with Biological Systems | Neuromorphic Computing 31 |

7. บทสรุปและข้อเสนอแนะเชิงกลยุทธ์

7.1. การสังเคราะห์การวิเคราะห์

การวิเคราะห์สนับสนุนสมมติฐานของผู้ใช้งานในประเด็นหลักทั้งหมด:

- ทางตันของ LLM: ขีดจำกัดด้านความสามารถในการให้เหตุผลเชิงตรรกะและความน่าเชื่อถือภายใต้สถาปัตยกรรม Transformer ได้รับการยืนยันในเชิงคณิตศาสตร์และวิชาการ 3 การขยายขนาดเพียงอย่างเดียวไม่สามารถแก้ไขปัญหาความน่าเชื่อถือในระดับวิทยาศาสตร์ได้

- ความเร็วและพลังทวีคูณ: ความเร็วของการพัฒนาและการใช้ AI Agents เป็นแรงขับเคลื่อนทางเศรษฐกิจที่สำคัญที่สุดในปัจจุบัน 16 Agents ได้เปลี่ยนสถานะของ AI จากเครื่องมือช่วยเหลือไปสู่ผู้ปฏิบัติงานอิสระที่เร่งกระบวนการจากแนวคิดสู่ผลิตภัณฑ์ (Idea-to-Product) อย่างมาก โดยเฉพาะในด้านการพัฒนาซอฟต์แวร์และการสร้างสรรค์ 13

- การทะลายกำแพงสู่ AGI: การก้าวข้ามขีดจำกัดทางปัญญาของ LLM ต้องอาศัยการเปลี่ยนผ่านเชิงสถาปัตยกรรม (MoR, Mamba) และเชิงปัญญา (World Models) โดย World Models จะมอบความสามารถในการให้เหตุผลเชิงเหตุผลที่จำเป็น 19

- การก้าวข้ามขีดจำกัดของมนุษย์: การไปสู่ปัญญาประดิษฐ์เหนือมนุษย์ (ASI) จะต้องอาศัย Recursive Self-Improvement (RSI) ซึ่ง AI สร้าง AI ที่ดีกว่าเดิม โดยมนุษย์ได้สร้างเทคโนโลยีที่ช่วยให้ AI สามารถออกแบบสถาปัตยกรรมที่ดีกว่าได้เองผ่าน Neural Architecture Search (NAS) แล้ว 26

7.2. ข้อเสนอแนะเชิงกลยุทธ์

สำหรับนักลงทุน, ผู้บริหาร R&D, และผู้นำเทคโนโลยีที่ต้องการรักษาความสามารถในการแข่งขันในยุคที่มีการเติบโตแบบทวีคูณ (Hyperbolic Growth) จำเป็นต้องมีการดำเนินการเชิงกลยุทธ์ในสองระดับ:

1. การลงทุนเพื่อความได้เปรียบทางเศรษฐกิจในระยะสั้น (2025–2027)

- มุ่งเน้นการปรับใช้ Agentic Frameworks: องค์กรต้องเปลี่ยนจากการ “ใช้ AI เป็นเครื่องมือ” ไปสู่ “การสร้างสถาปัตยกรรม Agents” ที่ทำงานอัตโนมัติ เพื่อให้ได้ประโยชน์สูงสุดจาก “ความเร็ว” ที่เพิ่มขึ้น 10 การลงทุนควรเน้นไปที่การบูรณาการ Agents เข้าสู่เวิร์กโฟลว์ที่มีทักษะสูง โดยเฉพาะอย่างยิ่งในการเขียนโค้ด, การวางแผนทางการเงิน, และการจัดการโครงการ

- การประเมินสถาปัตยกรรมที่ไม่ใช่ Transformer: เพื่อลดต้นทุนการประมวลผลและการใช้พลังงานในขณะที่เพิ่มบริบทให้ยาวนานขึ้น การทดลองใช้สถาปัตยกรรมใหม่ เช่น Mamba และ MoR เป็นสิ่งจำเป็น เพื่อให้แน่ใจว่าการปรับใช้ AI Agents มีความยืดหยุ่นและคุ้มค่าในเชิงเศรษฐศาสตร์.18

2. การวิจัยเพื่อการทะลุทะลวงเชิงปัญญาในระยะยาว (2028–2035+)

- การให้ความสำคัญกับ World Models และ Causal Reasoning: ต้องมีการลงทุนอย่างต่อเนื่องในการวิจัยเพื่อพัฒนาความสามารถในการวางแผนและการให้เหตุผลเชิงเหตุผลผ่าน World Models การพัฒนา AI ให้เป็นผู้สร้างสมมติฐาน (Hypothesis Generator) ในโดเมนที่ซับซ้อน (เช่น วิทยาศาสตร์การแพทย์หรือวิศวกรรม) ควรเป็นเป้าหมายหลัก เนื่องจากนี่คือกุญแจสำคัญในการก้าวข้ามขีดจำกัดการจับคู่รูปแบบของ LLM.21

- เร่งรัด NAS และความปลอดภัยของ RSI: ควรสนับสนุนการวิจัย Neural Architecture Search (NAS) และ Meta-Learning อย่างเต็มที่ เพื่อให้ระบบ AI สามารถปรับปรุงประสิทธิภาพของตนเองได้โดยไม่ต้องพึ่งพาข้อจำกัดทางสติปัญญาของมนุษย์ 27 อย่างไรก็ตาม การวิจัยนี้ต้องรวมการพัฒนาโปรโตคอลการพิสูจน์ความปลอดภัยทางคณิตศาสตร์ (Formal Verification) เข้าด้วยกัน เพื่อให้แน่ใจว่าการปรับปรุงตนเองแบบวนซ้ำ (RSI) เป็นไปในทิศทางที่สามารถตรวจสอบและควบคุมได้.26

ผลงานที่อ้างอิง

- The History of Artificial Intelligence | IBM, เข้าถึงเมื่อ ตุลาคม 23, 2025 https://www.ibm.com/think/topics/history-of-artificial-intelligence

- 2025 LLM Limitations: Research Review on the Real Boundaries of …, เข้าถึงเมื่อ ตุลาคม 23, 2025 https://ai.ksopyla.com/posts/illusion-of-thinking/

- Understanding the Core Limitations of Large Language Models: Insights from Gary Marcus, เข้าถึงเมื่อ ตุลาคม 23, 2025 https://odsc.medium.com/understanding-the-core-limitations-of-large-language-models-insights-from-gary-marcus-83176eb74c3f

- Language models and psychological sciences – PMC – PubMed Central, เข้าถึงเมื่อ ตุลาคม 23, 2025 https://pmc.ncbi.nlm.nih.gov/articles/PMC10629494/

- Will LLMs Scaling Hit the Wall? Breaking Barriers via Distributed Resources on Massive Edge Devices – arXiv, เข้าถึงเมื่อ ตุลาคม 23, 2025 https://arxiv.org/html/2503.08223v1

- [2507.19703] The wall confronting large language models – arXiv, เข้าถึงเมื่อ ตุลาคม 23, 2025 https://arxiv.org/abs/2507.19703

- Path to AGI – Part 2 – Hiflylabs, เข้าถึงเมื่อ ตุลาคม 23, 2025 https://hiflylabs.com/blog/2025/1/28/path-to-agi-part-2

- The Limitations and Challenges of Large Language Models (LLMS) – IDA, เข้าถึงเมื่อ ตุลาคม 23, 2025 https://www.intuitivedataanalytics.com/gne-blogs/the-limitations-and-challenges-of-large-language-models-llms/

- Beyond Transformers: Promising Ideas for Future LLMs – Apolo, เข้าถึงเมื่อ ตุลาคม 23, 2025 https://www.apolo.us/blog-posts/beyond-transformers-promising-ideas-for-future-llms

- AI Agents – Developer Roadmaps, เข้าถึงเมื่อ ตุลาคม 23, 2025 https://roadmap.sh/ai-agents

- What Are AI Agents? | IBM, เข้าถึงเมื่อ ตุลาคม 23, 2025 https://www.ibm.com/think/topics/ai-agents

- What are AI agents? Definition, examples, and types | Google Cloud, เข้าถึงเมื่อ ตุลาคม 23, 2025 https://cloud.google.com/discover/what-are-ai-agents

- Creative pros are leveraging Generative AI to do more and better work | Adobe Blog, เข้าถึงเมื่อ ตุลาคม 23, 2025 https://blog.adobe.com/en/publish/2024/02/02/creative-pros-generative-ai-usage

- How artificial intelligence impacts the US labor market | MIT Sloan, เข้าถึงเมื่อ ตุลาคม 23, 2025 https://mitsloan.mit.edu/ideas-made-to-matter/how-artificial-intelligence-impacts-us-labor-market

- What are AI agents? – GitHub, เข้าถึงเมื่อ ตุลาคม 23, 2025 https://github.com/resources/articles/what-are-ai-agents

- Productivity & the AI Revolution — Implications for the Economy and Markets – Citi, เข้าถึงเมื่อ ตุลาคม 23, 2025 https://www.citigroup.com/global/insights/productivity-the-ai-revolution-implications-for-the-economy-and-markets

- AI Will Transform the Global Economy. Let’s Make Sure It Benefits Humanity., เข้าถึงเมื่อ ตุลาคม 23, 2025 https://www.imf.org/en/Blogs/Articles/2024/01/14/ai-will-transform-the-global-economy-lets-make-sure-it-benefits-humanity

- Beyond Transformers: The MoR Revolution That’s Slashing AI Costs – Dinmay kumar Brahma, เข้าถึงเมื่อ ตุลาคม 23, 2025 https://dinmaybrahma.medium.com/beyond-transformers-the-mor-revolution-thats-slashing-ai-costs-5dfe2074d918

- How Far Are We From AGI: Are LLMs All We Need? – arXiv, เข้าถึงเมื่อ ตุลาคม 23, 2025 https://arxiv.org/html/2405.10313v2

- Large language models for artificial general intelligence (AGI): A survey of foundational principles and approaches – arXiv, เข้าถึงเมื่อ ตุลาคม 23, 2025 https://arxiv.org/html/2501.03151v1

- Google DeepMind’s new AI model just cracked a major cancer mystery, เข้าถึงเมื่อ ตุลาคม 23, 2025 https://indianexpress.com/article/technology/artificial-intelligence/google-deepminds-new-ai-model-just-cracked-a-major-cancer-mystery-10312337/

- NGENT: Next-Generation AI Agents Must Integrate Multi-Domain Abilities to Achieve Artificial General Intelligence – arXiv, เข้าถึงเมื่อ ตุลาคม 23, 2025 https://arxiv.org/html/2504.21433v1

- Characterizing and Efficiently Accelerating Multimodal Generation Model Inference – arXiv, เข้าถึงเมื่อ ตุลาคม 23, 2025 https://arxiv.org/abs/2410.00215

- Recursive Self-Improvement – AI Alignment Forum, เข้าถึงเมื่อ ตุลาคม 23, 2025 https://www.alignmentforum.org/w/recursive-self-improvement

- Recursive self-improvement – Wikipedia, เข้าถึงเมื่อ ตุลาคม 23, 2025 https://en.wikipedia.org/wiki/Recursive_self-improvement

- Meta’s AI Shows Self-Learning Breakthrough, Zuckerberg Calls It a Step Toward Superintelligence – AMW®, เข้าถึงเมื่อ ตุลาคม 23, 2025 https://www.amworldgroup.com/blog/meta-ai-takes-first-step-to-superintelligence

- Neural Architecture Search: Tools and Trends in 2024 – Analytics Insight, เข้าถึงเมื่อ ตุลาคม 23, 2025 https://www.analyticsinsight.net/deep-learning/neural-architecture-search-tools-and-trends-in-2024

- What Is AutoML? | IBM, เข้าถึงเมื่อ ตุลาคม 23, 2025 https://www.ibm.com/think/topics/automl

- EG-NAS: Neural Architecture Search with Fast Evolutionary Exploration | Proceedings of the AAAI Conference on Artificial Intelligence, เข้าถึงเมื่อ ตุลาคม 23, 2025 https://ojs.aaai.org/index.php/AAAI/article/view/28993

- Metalearning Machines Learn to Learn (1987-)., เข้าถึงเมื่อ ตุลาคม 23, 2025 https://people.idsia.ch/~juergen/metalearning.html

- NeuroMorphic Computing: Paving the Path to Advanced Artificial Intelligence | by Dean Martin | Medium, เข้าถึงเมื่อ ตุลาคม 23, 2025 https://medium.com/@deanmar/neuromorphic-computing-paving-the-path-to-advanced-ai-intelligence-e5530ed41f8f

- Neuromorphic computing: the future of AI | LANL, เข้าถึงเมื่อ ตุลาคม 23, 2025 https://www.lanl.gov/media/publications/1663/1269-neuromorphic-computing

- When Will AGI/Singularity Happen? 8,590 Predictions Analyzed – Research AIMultiple, เข้าถึงเมื่อ ตุลาคม 23, 2025 https://research.aimultiple.com/artificial-general-intelligence-singularity-timing/

- The case for AGI by 2030 – 80,000 Hours, เข้าถึงเมื่อ ตุลาคม 23, 2025 https://80000hours.org/agi/guide/when-will-agi-arrive/